Par Andy May

Un article initialement publié le 12 mars 2022 sur le site co2coalition.org.

Le grand débat sur le changement climatique entre les professeurs David Karoly et Will Happer (auquel s’est joint Glenn Tamblyn après le retrait de David Karoly) a donné lieu à un échange de points de vue intéressants sur la qualité des mesures de température par satellite versus les mesures de surface. Voici l’avis de Glenn Tamblyn :

« La compilation des données brutes relevées par plusieurs satellites est un processus très complexe. Il s’ensuit que les ensembles de données satellitaires sont beaucoup moins précis que les ensembles de données de température de surface…L’accent mis par le professeur Happer sur les mesures de température par satellite ne concorde pas avec l’opinion des experts en la matière.

(Tamblyn, 2021b, p. 7-8)

Les satellites mesurent le rayonnement micro-ondes émis par les molécules d’oxygène présentes dans l’atmosphère et estiment une température de « luminosité » qui peut ensuite être convertie en une température atmosphérique réelle. Aucun calibrage avec d’autres mesures n’est requise. La luminosité mesurée est comparée à la température de luminosité de l’espace lointain (-455 ° F) et à une cible de température connue à l’intérieur du satellite pour calculer la température réelle dans l’atmosphère. [1]

En raison des interférences et des nuages, cette technique ne fonctionne pas près de la surface, de sorte que les températures atmosphériques des satellites ne peuvent pas être directement comparées aux mesures de surface. Les mesures par satellite sont les meilleures pour mesurer les températures de l’air dans la moyenne troposphère et la basse stratosphère.

Le Hadley Center estime l’incertitude de la température moyenne mensuelle mondiale de surface (Sea Surface Temperature) entre 2000 et 2021 à ± 0,033 °C et David Karoly a donné une estimation de ± 0,1 ° C. La précision est inférieure à celle estimée par Roy Spencer et John Christy pour leurs mesures par satellite qui est de ± 0,011 ° C en moyenne mensuelle. [1]

Compte tenu de ces analyses peer-reviewed (révisées par les pairs), nous pouvons raisonnablement supposer que les données satellitaires sont au moins aussi précises que les données de surface, sinon plus précises. En outre, les données satellitaires couvrent un plus grand volume d’atmosphère et mesurent uniformément une plus grande partie du globe que les données de surface.

Tamblyn semble penser que les données utilisées pour créer les mesures par satellite provenant de plusieurs satellites, cela implique nécessairement que les températures issues des mesures satellitaires sont moins précises. Ceci est incorrect car les données issues des divers satellites sont fusionnées selon une procédure précise décrite par John Christy. [2]

Il faut aussi rappeler que les mesures de surface sont sujettes à une plus grande volatilité et à d’importantes variations diurnes, tandis que les mesures des satellites sont faites à une altitude plus élevée dans l’atmosphère, dans un environnement plus stable, et sont mieux adaptées à l’estimation du changement climatique que les relevés météorologiques de surface.

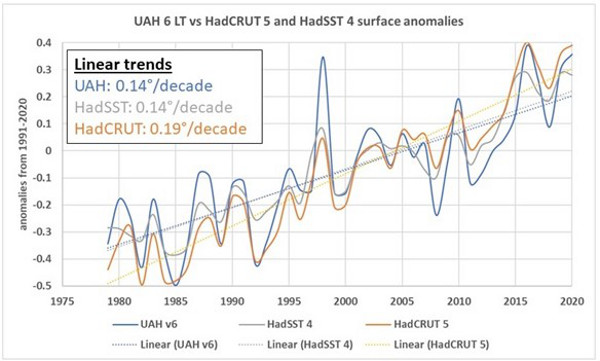

Dans la figure 1 ci-dessus représente l’évolution des températures de la basse troposphère (centrées à une altitude d’environ 10 000 pieds [3 000 mètres] ) issues des mesures satellitaires UAH (courbe bleu clair). Elle est comparée à celle des températures HadSST4 de la surface de la mer du Hadley Center (courbe grise) et aux températures HadCRUT5, ensemble des données de température de surface sur les terres et les océans ( courbe orange).

Will Happer indique de façon claire que les satellites mesurent une température différente avec une couverture constante et quasiment mondiale. Les mesures au sol, en revanche, sont rares, espacées dans le temps et effectuées avec de nombreux appareils différents.

Sur la figure 1, nous pouvons voir que les tendances au réchauffement de la basse troposphère données par les satellites HadSST et UAH sont identiques (0,14°C par décennie). La principale différence est que les phénomènes El Niño et La Niña sont plus intenses dans la basse troposphère qu’en surface. Les deux El Niño de forte intensité (1998 et 2016) sont visibles, de même que les forts événements La Niña de 2008 et 2011.

Les températures HadCRUT sont bien inférieures aux HadSST et UAH au début de la période et supérieures à la fin. Elles donnent un taux de réchauffement de 0,19°C par décennie, soit de 36% supérieures. Cette différence dans les taux de réchauffement s’explique par l’ajout aux SST (Température de surface de la mer) des températures de surface au-dessus des terres, même si celles-ci ne représentent que moins de 30 % de la surface de la Terre.

La figure 1 nous amène aux trois conclusions importantes suivantes :

- Lors des années El Niño, une température de surface plus chaude conduit à plus d’évaporation, qui transporte la chaleur de la surface de l’océan vers la basse troposphère. Lorsque l’eau évaporée se condense en gouttelettes, généralement dans les nuages, elle libère la chaleur d’évaporation dans l’air ambiant. Les températures UAH de la basse troposphère tracée à la figure 1, sont les plus sensibles aux températures autour de 10 000 pieds [3 000 mètres], bien qu’elles englobent certaines émissions à une altitude inférieure à 6 500 pieds [3 000 mètres], une altitude où se trouvent les nuages .

- Étant donné que le taux global de réchauffement des données HadSST est à peu près le même que le réchauffement de la basse troposphère UAH, cela suggère que le réchauffement supplémentaire enregistré par les données terrestres et océaniques HadCRUT5 est suspect.

- Enfin, si les données HadCRUT5 étaient correctes, cela voudrait dire que la surface se réchauffe plus rapidement que la troposphère inférieure et moyenne. Si cela est vrai, les modèles utilisés par le GIEC dans ses rapports suggèrent que ce réchauffement n’est pas dû aux gaz à effet de serre (GES). Il se pourrait que le réchauffement additionnel de la troposphère au-dessus de 6 500 pieds [3 000 mètres], soit dû aux phénomènes El Niño et non aux GES. Il est difficile d’admettre que les courbes de la figure 1 soient à la fois exactes et cohérentes avec l’idée que les GES provoquent le réchauffement de la surface. Pour une discussion plus approfondie de la relation entre les GES et l’écart entre le réchauffement de surface et celui de la troposphère moyenne, on pourra se référer à l’un de mes précédents articles.

En résumé, les deux méthodes courantes utilisées pour la détermination de la température moyenne mondiale (satellite et surface), sont probablement précises au dixième de degré près, comme le suggère Karoly. Ces deux méthodes montrent que le monde se réchauffe, mais l’estimation du réchauffement de surface HadCRUT5 de 0,19°C par décennie est significativement plus élevé que celui de la basse troposphère satellitaire estimé à 0,14°C par décennie. Le réchauffement plus important de la surface est un artefact des mesures des températures de la surface terrestre ou de leurs ajustements. Les ajustements apportés aux mesures de température de la surface terrestre CRUTEM5 et au réseau mondial de climatologie historique (GHCN) ou similaire, sont importants et controversés, comme l’expliquent Peter O’Neill et une liste impressionnante de coauteurs. Pour être clair, O’Neill, et al. ont évalué les données du Global Historical Climatology Networket (GHCN) et non celles du CRUTEM5, mais les ajustements apportés à chacun de ces jeux de données sont similaires et ils ont tous les deux les mêmes faiblesses. L’explication d’un écart de 36% entre le réchauffement de l’océan et celui de la terre plus océan n’est pas claire et suggère un problème avec les données CRUTEM5 de la température terrestre.

Téléchargez la bibliographie ici .

- (Spencer & Christy, 1990)

- (Christy, Spencer et Braswell, 2000)

- (Kennedy, Rayner, Atkinson et Killick, 2019) et (Karl, Williams, Young et Wendland, 1986)

- (GIEC, 2021, pp. Figure 3-10, page 3-162) et (GIEC, 2013, pp. Figure 10.8, page 892). La dépendance de la tendance au réchauffement de la haute troposphère sur l’effet de serre du CO2 est plus facilement visible dans le rapport AR5 2013 puisqu’ils présentent le réchauffement naturel en bleu et le réchauffement par effet de serre en vert dans leur figure.

- (O’Neill, et al., 2022)

Article remarquable.

Quelques remarques :

1. Il y a polémique sur l’amplitude des ajustements effectués sur les données des stations météos. Ces ajustements sont par exemple très faibles pour BEST. Le problème est en fait méthodologique. BEST comme CRUTem et les autres fournisseurs cherchent à conserver les tendances à courts termes des tronçons homogènes. La seule manière efficace d’évaluer le biais méthodologique induit est de calculer les tendances à longs termes des longues séries brutes. Pour tous les fournisseurs, on obtient un biais méthodologique d’au moins 0.07 °C par décennie sur la seconde moitié du XXème siècle.

2. Si le réchauffement de la basse troposphère était réelement inférieur à celui de la surface, cela signifierait que l’on ne comprend strictement rien à la physique de l’atmosphère. C’est très improbable.

3. May ne parle malheureusement pas du phénomène d’amplification troposphérique. Si les données satellitaires sont correctes, et tout porte à le penser, on peut, en tenant compte de l’amplification troposphérique, obtenir une évolution plus fiable des températures de surface (voir ici : https://www.zupimages.net/up/22/16/804k.png).

Juste une remarque ironique:

Concernant l’évolution des températures globales, le GIEC préfère écarter les données satellitaires UAH et RSS parce que pas assez catastrophiques et difficiles à « ajuster » (disons plutôt « manipuler »).

C’est bien le contraire avec l’évolution du niveau marin: Le GIEC se fie aveuglément aux données satellitaires nettement plus catastrophiques, outre leur incohérence, que les données de centaines de marégraphes installés pour certains depuis des décennies, voire même près de deux siècles (celui de Brest) un peu partout à travers le monde. L’association de ces derniers avec des balises altimetriques GPS a permis d’améliorer leur precision de façon considérable.

Les appareils embarqués reçoivent un signal provenant de toute la colonne atmosphérique. Il est dit que que l’information est « centrée autour de 3000 m ». Pouvez-vous préciser comment ce « centrage » est effectué ? Je suppose qu’il y a de la modélisation en jeu, car le gradient de température dans la troposphère varie de 9°C/km pour de l’air sec à 6,5°C/km pour de l’air humide.

« Centré autour de 3000 m » signifie que le signal provient d’altitudes plus basses et plus hautes, avec une distribution ?

Comment établit-on, dans ces conditions, une correspondance avec des mesures directes au niveau du sol ?? .

Merci de vos précisions.

La sélection des altitudes se fait sur la base de l’opacité aux différentes longueurs d’ondes utilisées. Vous avez là un schéma montrant les poids pour les différents produits :

https://bobtisdale.files.wordpress.com/2014/04/tlt-tmt-tls-weighting.png

Il n’y a pas de conversion directe possible entre TLT et mesures de surface. C’est un point qui est très généralement oublié et les deux grandeurs sont trop souvent représentées sur les mêmes graphiques sans précaution.

Dans mon précédent message ci-dessus, j’ai montré comment on pouvait comparer les TLT aux T2m.

Je vois que la fonction de poids (weighting function) pour la basse troposphère tient compte des températures sur environ 10 km de hauteur. C’est sans doute la raison pour laquelle il n’y a pas de conversion directe possible entre TLT et températures de surface (TS), Comment peut-on alors critiquer les TS au nom des TLT ?

Quelle incertitude existe sur la fonction de poids ?

Ne faudrait-il pas assortir la valeur trouvée pour la variation de T par décennie d’une incertitude ?

« Comment peut-on alors critiquer les TS au nom des TLT ? »

A moins que les bases de la physique de l’atmosphère soient erronées mais c’est très peu probable, il faut bien constater une grave incohérence entre ces deux variables. L’une ou l’autre est assurément fausse, peut-être les deux.

Cette seule comparaison ne permet de conclure. On peut raisonnablement supposer que ce sont les Ts qui sont déficientes parce qu’elles sont incohérentes avec à peu près toutes les variables connues dépendants de la température comme le niveau des océans, la fonte des glaciers, l’enneigement et autres proxies de la température. De plus, certaines caractéristiques propres aux mesures de surface et aux méthodes de traitement des données laissent fortement supposer un biais important dans les tendances à long terme. A priori, les TLT ne sont pas concernées par ces faiblesses spécifiques.

La divergence entre les deux grandeurs est d’environ 0.1 °C par décennie soit à peu près la même valeur qu’entre les Ts et les autres variables climatiques citées plus haut.

Bonjour,

Je ne vois pas cette « grave incohérence » que vous mentionnez, mais peut-être faites-vous allusion à d’autres données que celles montrées sur la figure de l’article. Les fluctuations se situent aux mêmes endroits, seules leurs amplitudes diffèrent.

Mais je réitère ma question : quelle incertitude sur la valeur de la pente de chaque série de données ?

Remarque : il est normal que la pente des données de la seule surface des océans soit inférieure à celle qui tient compte aussi des terres.

Quand les températures augmentent, l’humidité absolue augmente ce qui provoque une diminution du lapse rate. Donc, il y a amplification des variations de température dans la troposphère par rapport à la surface. Cette amplification est parfaitement visible dans les fréquences moyennes sur le graphique de l’article et elle vaut à peu près 1.5. Elle devrait nécessairement se retrouver dans les tendances à longs termes or elle en est absente ici et il y aurait même une atténuation troposphérique sur les continents.

Il y a donc quelque chose de faux soit dans notre compréhension de la physique de l’atmosphère soit dans l’un ou l’autre de ces jeux de données.

Pour ce qui est de l’incertitude, il n’y a rien de plus incertain que son évaluation.

Finalement, je ne crois pas que la divergence de l’évolution des températures sur les continents par rapport aux océans soit normale. Phil Jones pensait qu’elle révélait un problème dans les mesures et je suis du même avis.

Vous allez trop vite pour moi.

Lapse rate ?

« Fréquences moyennes » de quoi ? Vous voulez parler de l’amplitude de fluctuations ?

« Se retrouver dans les tendances à long terme » : c’est-à-dire ?

Si l’on ne peut caractériser les incertitudes, on ne peut rien dire de la comparaison des valeurs absolues

T(continent) versus T(océan) : un simple effet de chaleur spécifique ? Le sable peut-être brûlant au bord de la mer, l’eau ne l’est pas souvent…

– Le lapse rate est le gradient thermique vertical dans l’atmosphère.

– Oui, si vous voulez, l’amplitude. Il s’agit de courbes lissées donc sans hautes fréquences. Les basses fréquences sont assimilées ici à la tendance.

– Si la variation de température de surface est amplifiée dans la troposphère, alors le réchauffement sur 40 ans devrait également être plus important dans la troposphère. Le graphique de l’article montre au contraire un réchauffement troposphérique atténué.

– On peut bien évaluer l’incertitude liée par exemple à une mesure instrumentale. Dans le cas particulier, cette incertitude est pratiquement nulle vu le nombre très important de mesures. Le problème n’est pas donc pas dans des marges d’erreurs qui seraient facilement évaluables mais dans les méthodes d’acquisition et de traitement des données. Potentiellement, ces méthodes sont susceptibles de provoquer des biais bien supérieurs à la tendance à long terme.

– La différence entre continents et océans est avant tout inertiel. Cette différence d’inertie est observable dans les hautes fréquences et ne dépasse pas quelques semaines.

Bonjour,

Merci pour ces précisions. Je reviens sur le gradient thermique car je ne comprends pas votre argument.

Le gradient thermique pour un air sec est d’environ 9 °C/km (gradient adiabatique). Il est de 6,5 °C/km pour un air humide. Donc il diminue avec l’humidité (relargage de la chaleur latente de condensation).

Pourquoi dites-vous que les variations de température de surface devraient être amplifiées dans la troposphère ? Pouvez-vous détailler le mécanisme ?

La valeur du gradient adiabatique humide est très variable dans les conditions de la troposphère (environ entre 3 et 10 °C par km). Le 6.5 °C par km est autre chose, il s’agit d’un gradient moyen de caractère conventionnel qui n’a rien à voir avec l’adiabatique. Les conditions adiabatiques ne sont pas remplies dans la troposphère à cause des flux thermiques radiatifs (GES). On ne s’approche d’un comportement adiabatique que dans les masses d’air en rapide déplacement vertical qui n’intéressent qu’une petite fraction de la masse troposphérique.

Cela dit, vous avez parfaitement raison, le gradient thermique diminue avec l’augmentation de la vapeur d’eau. Et comme la vapeur d’eau augmente avec la température, le gradient thermique diminue avec la température. Cela veut dire que pour une augmentation de la température de surface, vous avez :

a) une augmentation de la température de la troposphère de la même valeur par translation du profil thermique,

b) une augmentation de la même température par rotation du profil thermique avec pivot à la surface.

Il y a donc amplification des variations de température dans la troposphère par rotation du profil thermique.

Cette amplification est bien visible sur le graphique de l’article dans les moyenne fréquences mais curieusement pas dans les tendances.

Bonsoir,

Deux remarques :

1. Vous dites que les mouvements ascendants ne concernent qu’une petite fraction de l’atmosphère. Certes, mais si ce sont ces mouvements qui induisent les grandes variations de température, et non les mouvements horizontaux, ce sont quand même eux qui déterminent le gradient thermique, non ? Les flux radiatifs sont incapables d’induire de pareilles variations de température.

2. « Rotation du profil thermique : qu’est-ce que c’est ??

1. Non, ce ne sont justement pas ces mouvements qui produisent des différences de températures. Il ne peuvent strictement qu’atténuer des différences préexistantes jusqu’à concurrence du gradient adiabatique. Seuls les phénomènes radiatifs sont à l’origine des différences de température (absorption du rayonnement solaire par la surface et rayonnement des GES vers l’espace). Le refroidissement radiatif agit partout et toujours alors que les mouvements convectifs rapides n’intéressent qu’une petite fraction de la masse troposphérique.

2. La rotation du profil thermique est simplement une représentation géométrique de la modification du gradient thermique.

Je crois que vous faites erreur : le gradient adiabatique, comme son nom l’indique d’ailleurs, est dû aux mouvements convectifs de l’atmosphère, et non aux échanges radiatifs. Tout cela est détaillé dans mon papier avec Jean-Louis Dufresne.

Le gradient adiabatique est juste le gradient thermique d’une masse d’air en mouvement vertical quand cette masse d’air n’échange aucune chaleur avec l’environnement. A cause de la présence des GES, ces conditions ne sont approchées dans l’atmosphère que dans les masses d’air en rapide déplacement vertical. Le gradient moyen de la troposphère n’est en rien un gradient adiabatique même si la convection a bien entendu un rôle dans la formation de sa valeur.

D’autre part, s’il y a convection, c’est qu’il y a source froide en haut et source chaude en bas. Ces deux sources sont des phénomènes radiatifs. Ce sont eux qui déstabilisent la colonne troposphérique. La convection qui évacue la plus grande partie de l’énergie produite à la surface ne peut ainsi qu’atténuer un gradient préexistant. Elle ne peut en aucun cas être à l’origine de ce gradient.

Vous faites une confusion entre cause et conséquence : la cause de la convection est la poussée d’Archimède, le gradient adiabatique est une conséquence.

Bonjour,

Vous ne pouvez pas dire à la fois une chose et son contraire : « le gradient n’est en rien un gradient adiabatique » et « la convection a bien entendu un rôle ».

Quel rôle ?

La source chaude en bas est due à l’absorption du rayonnement solaire. Mais la source froide en haut est justement due à la détente.des masses ascendantes et la compression des masses descendantes.

Désolé, phrase maladroite : c’est le gradient qui est dû à la détente des masses ascendantes et à la compression des masses descendantes.

Bonjour à vous,

1. Le gradient thermique n’est en rien un gradient adiabatique parce que les conditions adiabatiques, soit absence d’échanges de chaleur, ne sont pas respectées dans la masse troposphérique. Cela dit, la convection transporte de la chaleur vers le haut ce qui atténue ce gradient. L’effet sur la température de la détente et de la compression ne correspondent qu’à une limitation de l’efficacité de ce moyen de transport.

2. La cause de la convection est la poussée d’Archimède mais il ne faut pas s’arrêter là. La cause de la poussée d’Archimède est le fait, par exemple pour les masses ascendantes, qu’elles sont plus chaudes que l’environnement. En d’autres termes, une masse d’air ne s’élève que dans un environnement ayant un dT/dz plus négatif que le gradient adiabatique. Le refroidissement par les GES dans la masse troposphérique crée ce gradient négatif et déstabilise la colonne. C’est donc bien le gradient thermique, trop négatif, qui est la cause de la convection. L’effet de cette convection étant seulement une atténuation d’un gradient thermique négatif préexistant.

Bonsoir,

Dans les quelques premiers kilomètres de la troposphère, le rayonnement émis vers le haut par les GES contenus dans une couche atmosphérique est totalement absorbé par les couches supérieures. Donc le mécanisme de refroidissement par les GES que vous invoquez n’existe pas. La notion d’altitude d’émission est justement là pour rendre compte de ce fait. Evidemment, cette altitude n’est pas unique, elle dépend de la longueur d’onde, et varie entre disons 3 et 8 km.

Le gradient thermique est bien principalement dû à la détente adiabatique des masses d’air chaudes à la montée (équateur) ou à la compression adiabatique de masses d’air froides à la descente (limite nord de la cellule de Hadley). Pareil pour les autres cellules atmosphériques.

Avez-vous une référence qui soutienne votre point de vue d’un « gradient thermique préexistant » ?

.

Bonjour,

1.

« Dans les quelques premiers kilomètres de la troposphère, le rayonnement émis vers le haut par les GES contenus dans une couche atmosphérique est totalement absorbé par les couches supérieures. »

Le spectre IR de la planète vue de l’espace montre que le rayonnement vient de toute la colonne, donc y compris des basses couches : https://planet-terre.ens-lyon.fr/planetterre/objets/Images/imagerie-satellite2/imagerie-satellite2-fig16.jpg

La fenêtre atmosphérique est ici assez large mais on voit que pour ce qui est de la colonne troposphérique, elle est bien représentée sur toute sa hauteur.

2.

« Donc le mécanisme de refroidissement par les GES que vous invoquez n’existe pas. »

Bien sûr qu’il existe et personne ne le met en doute sérieusement. Où donc irait la chaleur transmise de la surface à l’atmosphère sans ce mécanisme ?

3.

« La notion d’altitude d’émission est justement là pour rendre compte de ce fait. »

La notion d’altitude d’émission rend compte de quelque chose d’assez flou mais c’est en principe l’altitude correspondant à la température d’équilibre radiatif de la planète. Il y a en gros autant d’énergie évacuée en-dessous de cette altitude qu’en-dessus.

4.

« Le gradient thermique est bien principalement dû à la détente adiabatique des masses d’air chaudes à la montée (équateur)… »

L’air réchauffé à la surface ne monterait pas si la colonne n’était pas plus froide en altitude et, étant alimentée en chaleur par la convection, elle ne peut demeurer froide que si les GES la refroidissent.

5.

« …ou à la compression adiabatique de masses d’air froides à la descente (limite nord de la cellule de Hadley). »

A la descente, la compression est sèche et donc on devrait avoir 10 °C par km partout où il y a subsidence. Est-ce le cas ? Non bien sûr. Le gradient réel est plus faible parce que la descente est lente et que la masse se refroidit grâce aux GES en permanence.

6.

« Avez-vous une référence qui soutienne votre point de vue d’un “gradient thermique préexistant” ? »

Oui. Bien sûr. Pas besoin d’aller plus loin que Wikipedia :

« Le mouvement convectif ascendant est causé par la différence de température entre la parcelle d’air soulevée et l’environnement plus froid en altitude. »

Nous cherchons à comprendre l’origine du gradient thermique, n’est-ce pas ? Je prétends que ce sont les mouvements convectifs de l’atmosphère, déclenchés par les variations de la température du sol, et vous dites qu’il y a une « autre cause » préexistante liée aux GES.

Je vous disais dans mon précédent message que, dans la mesure où l’altitude démission de rayonnement par les GES était comprise entre environ 3 et 8 km, ce phénomène ne pouvait pas expliquer un gradient dans les premiers kilomètres de la troposphère, car le rayonnement n’est que transmis de couche en couche.

Le spectre IR vu de l’espace confirme bien ce point. En effet, vous voyez clairement que pour les longueurs d’onde absorbées par les GES (CO2, H2O et O3), les températures de corps noir correspondent à des altitudes de plusieurs kilomètres. La température de surface correspond à la « fenêtre atmosphérique », i.e. les longueurs d’onde que les GES ne peuvent absorber. Pour le dire schématiquement, l’altitude d’émission est telle qu’en dessous, le rayonnement émis par les couches atmosphériques ne sort pas de l’atmosphère, au dessus, tout s’échappe (cf; article Dufresne-Treiner).

Pour avoir des mouvements convectifs, il suffit qu’existent des différences de température de surface : là où c’est plus chaud, ça monte par poussée d’Archimède.

Ensuite, la convection fait le gradient.

Il faut faire mieux que Wikipedia : que signifie: « la parcelle d’air soulevée » ? Pourquoi est-elle soulevée ? Et que se passe-t-il après ? .

Je rajoute que ce mécanisme s’observe à petite échelle également, et qui explique parfois le changement de sens du vent au bord de la mer l’été : de la mer vers la terre le jour, de la terre vers la mer la nuit.

Bonjour,

Pour l’essentiel, je vous renvoie aux 6 points de mon message précédent mais je vous réponds plus en détail sur ceci :

« Pour avoir des mouvements convectifs, il suffit qu’existent des différences de température de surface : là où c’est plus chaud, ça monte par poussée d’Archimède.

Ensuite, la convection fait le gradient. »

Pas des différences de température de surface, des différences dans la colonne. Une bulle d’air chauffée ne s’élève pas parce qu’il fait plus froid en surface à 1000 km de là mais parce qu’elle baigne dans un environnement plus froid. Elle ne montera spontanément que tant et aussi longtemps qu’elle sera plus chaude que son environnement.

Même si la température de la bulle va se refroidir selon le gradient adiabatique en montant, elle ne peut jamais faire autre chose qu’augmenter la température dans la troposphère donc atténuer un dT/dz plus négatif que l’adiabatique.

La convection ne fait pas le gradient, elle y réagit. Elle stabilise une colonne déstabilisée par les phénomènes radiatifs.

Manabe et Strickler 1964 :

« The observed tropospheric lapse rate of température is approximately 6,5°C/km. The explanation for this fact is rather complicated. It is essencially the result of a balance between (a) the stabilizing effect of upward heat transport in moist and dry convection on both small and large scales and (b) the destbilizing effect of radiative transfer. »

Une bulle d’air chaud monte parce qu’elle est poussée par en dessous, et non parce qu’elle serait attirée par le haut (?!).

Il suffit qu’elle soit plus chaude que l’air à sa frontière de bulle. Reprenez l’exemple d’un bord de mer. Le jour, l’air monte au dessus du sable car le sable est plus chaud que la mer, donc l’air au dessus du sable est plus chaud que l’air au dessus de la mer, d’où une brise de mer. La nuit c’est le contraire.

Pouvons-nous nous mettre d’accord sur ce bout de physique de base ?

Brises de terre et brises de mer sont des phénomènes météorologiques locaux liés à des différences de température en surface. Je crains ne pas pouvoir vous suivre plus loin.

La brise de mer est provoquée par la dépression locale régnant sur les terres en journée. Cette dépression est due à l’ascendance de l’air chauffé en surface. Ascendance qui est une réaction à un déséquilibre hydrostatique; du chaud en bas déstabilise la colonne si le dT/dz est plus négatif que le gradient adiabatique. Cas d’antécédence du gradient thermique que nous avons déjà abordé.

La brise de terre est, elle, provoquée par le refroidissement nocturne de l’air au contact du sol dans les reliefs modérés. Cet air s’écoule gravitairement en direction du littoral. Une source froide à la surface conjuguée avec un gradient de pression tendent donc à inverser le gradient thermique.

Aucun de ces deux mécanismes ne permet d’invoquer des différences dans les températures de surface pour expliquer le gradient thermique moyen observé dans la troposphère.

(Suite)

Et pourquoi ne généralisez-vous pas le raisonnement à la structure de la cellule de Hadley ? L’air monte au dessus de l’équateur car la surface est en moyenne plus chaude qu’aux plus hautes latitudes, ce qui génère en surface les alizés. Je ne vois pas ce qui empêcherait cette montée d’être adiabatique (pour de l’air humide). Pareil pour la limite nord de cette cellule, où l’air est sec à la descente. La stabilité de cette structure montre qu’elle résiste à des variations de conditions locales.

Le même raisonnement explique aussi la cellule circumpolaire.

Vous avez là un schéma explicatif des grandes structures de la troposphère. Quel est le vôtre ?

L’air ne monte pas sur l’équateur parce qu’il fait plus froid aux hautes latitudes mais parce que la colonne est déstabilisée par de l’air léger en bas. Il se forme alors une haute pression d’altitude et un écoulement en haute troposphère vers les dépressions d’altitude, vers les subsidences. Ces zones correspondent à des hautes pressions de surface et donc à des vents de surface des hautes vers les basses latitudes. La boucle est ainsi bouclée. Le moteur d’une cellule convective est, dans le conditions de l’atmosphère, un dT/dz trop négatif provoqué conjointement par le chauffage de la surface et le refroidissement dans la masse par les GES.

C’est le sens de ce passage de Manabe et Strickler que je reproduis encore une fois par ce qu’il est important :

« The observed tropospheric lapse rate of température is approximately 6,5°C/km. The explanation for this fact is rather complicated. It is essencially the result of a balance between (a) the stabilizing effect of upward heat transport in moist and dry convection on both small and large scales and (b) the destbilizing effect of radiative transfer. »

Une source froide en surface ne peut pas engendrer de la convection dans la masse atmosphérique parce que l’air refroidi est plaqué au sol. Les mouvements horizontaux se font alors nécessairement dans des conditions d’inversion du gradient thermique.

Bonsoir,

Vous dites : « la colonne est déstabilisée par de l’air léger en bas ».

Pourquoi est-il plus léger à l’équateur ?

Pouvez-vous décrire simplement les mouvements atmosphériques associés à la cellule de Hadley ?

Votre citation ne donne pas ce mécanisme. Je note cependant qu’ils font allusion à des mouvements de convection à petite et grande échelle, alors qu’au début de nos échanges, vous disiez que la convection ne concernait que de petites masses atmosphériques.

Je n’ai bien entendu pas prétendu que les différences de températures de surface ne jouaient pas de rôle dans la circulation atmosphérique. Simplement, le refroidissement dans la masse par les GES est le moteur de cette circulation et l’explication d’un dT/dz négatif. Une source froide en surface ne peut que créer une inversion des températures.

Dans le cas des cellules de Hadley, les zones de subsidences dans les 30° de latitude sont d’ailleurs des sources chaudes et pas des sources froides. Si cette circulation particulière s’établit malgré tout, c’est une question de rapport des pressions; d’où ma description un brin compliquée du phénomène.

Votre description n’est pas compliquée, elle est erronée. Le gradient thermique ne peut être dû aux GES, car leurs émissions radiatives sont absorbées par les couches supérieures de l’atmosphère jusqu’à plusieurs kilomètre d’altitude, cf. en particulier les travaux de JL Dufresne.

Que ce gradient thermique soit dû, à l’ordre zéro, à la convection humide est communément accepté depuis les années 1990, cf. sur ce point les travaux de Kerry Emmanuel et ses collaborateurs.

Je pense que nous pouvons arrêter là les échanges, je ne vois pas comment ils pourraient progresser devant une incompréhension si basique des principaux phénomènes en jeu.

Je vais vous poser une question. En 1964, Manabe a écrit que la colonne troposphérique était déstabilisée par les échanges radiatifs (voir la citation ci-dessus). Il découle de cette affirmation que la convection est une conséquence des échanges radiatifs, donc la conséquence d’un gradient thermique trop prononcé. Pouvez-vous me donner la référence vers une étude démontrant que Manabe se trompait ?

Non Jacques Treiner, les bases, je les maîtrise. Ce qu’écrivait Manabe en 1964 n’est rien d’autre que le b.a.-ba de la thermodynamique de l’atmosphère, jamais démenti.

Pour vous et pour quelque improbable lecteur de ces échanges, il serait grand temps de faire face à la réalité et de prendre conscience de l’invraisemblable dérive de certains prétendus scientifiques.

Bonjour,

Je vous rappelle que le début de nos échanges concernaient l’origine du gradient thermique, les fameux 6,5°C/km (ou 9°C/km pour de l’air sec). Vous contestiez que c’était la convection qui expliquait ces valeurs.

Je pense que vous comprenez mal la phrase de Manabe. Il est vrai que l’échappement du rayonnement vers l’espace refroidit l’atmosphère par le haut. Ceci induit les mouvements de convection (c’est cela l’effet déstabilisateur), processus « stabilisant » car transférant de la chaleur de la surface vers le haut. Mais ce sont bien ces processus de convection, rapides, qui fixent la valeur du gradient thermique.

Retour au point de départ.

Bonjour,

Les 6.5 utilisés par Manabe ne représentent pas un gradient adiabatique plus ou moins humide mais un gradient empirique.

La phrase de Manabe n’est en rien équivoque. Le gradient observé est difficile à expliquer (et impossible à calculer) parce qu’il a pour origine le refroidissement de l’atmosphère par les GES mais qu’il est également influencé par l’effet stabilisant de la convection.

Il n’y a strictement aucune raison pour que les ascendances rapides représentant une masse très marginale dictent à elles seule le gradient thermique à l’ensemble de la troposphère.

Bonjour,

Votre première phrase est étrange : en quoi le fait que la valeur du gradient soit empirique (i.e. mesurée) s’oppose-t-il à ce que ce soit un gradient adiabatique ?? Le but de l’activité scientifique consiste à trouver des explications à ce que l’on observe, n’est-ce pas ? On calcule un gradient adiabatique sec, on trouve 9°/km. On considère de l’air humide, on trouve la bonne valeur empirique. Et l’un n’a rien à voir avec l’autre ??

Il n’y a pas que les ascendances qui sont concernées, l’argument vaut aussi pour les mouvements descendants (compression adiabatique). Quant aux masses d’air concernées, notez tout de même que sans les mouvements verticaux, il n’y a pas de mouvements horizontaux…

Le mécanisme est bien compris par les spécialistes (dont nous ne sommes ni vous ni moi) : la colonne est déstabilisée par l’émission de rayonnement en haute altitude, et les mouvements de convection fixent le gradient.

C’est ce que disent les spécialistes que j’ai consultés. En avez-vous trouvé qui vous disent autre chose ?

Bonne nouvelle année,

La convection ne pourrait expliquer seule le gradient thermique de la troposphère que si elle était seule à y assurer les transferts thermiques. Le gradient y serait alors adiabatique et calculable.

Ce n’est évidemment pas le cas puisque le flux thermique radiatif dans la troposphère est d’environ 20 W/m2 (17%) près de la surface et que sa part progresse régulièrement pour atteindre 100% à la tropopause pour un flux total très réduit.

Le gradient n’est donc pas calculé mais fixé empiriquement sous la condition erronée qu’il serait entièrement déterminé par la convection.

Ni Manabe ni les autres théoriciens n’ont prétendu que le gradient troposphérique était un gradient adiabatique. Ils parlent de gradient critique mais pas de gradient adiabatique.

Et encore une fois, la grosse masse de la troposphère est en lente subsidence. Si les conditions adiabatiques étaient réunies, nous devrions mesurer un gradient moyen proche de 10 °C/km et pas de 6.5 °C/km. C’est la meilleure preuve de l’importante contribution radiative au gradient thermique.

Pour terminer, spécialiste n’est pas une marque déposée et la question sur la table est précisément la compréhension du problème par ceux qui se présentent comme tels. Le spécialiste couronné par un Nobel est Manabe et je reproduis encore une fois ce qu’il a écrit en 1964 :

“The observed tropospheric lapse rate of température is approximately 6,5°C/km. The explanation for this fact is rather complicated. It is essencially the result of a balance between (a) the stabilizing effect of upward heat transport in moist and dry convection on both small and large scales and (b) the destbilizing effect of radiative transfer.”

Une évidence conforme à la thermodynamique et qui n’a bien entendu jamais été réfutée.

Je suis prêt à discuter de tout cela ici directement avec ceux que vous tenez pour des spécialistes.