Un article de Roy Clark traduit par Camille Veyres.

Source : Understanding The Seven Major Errors In Climate Models – Climate Change Dispatch

[Note du traducteur : cette présentation résume un article de 73 pages publié par la revue Science of Climate Change.

Il y a au moins sept erreurs majeures dans les modèles climatiques. Cinq d’entre elles proviennent d’idées trop simplifiées sur la façon dont l’énergie se déplace. Une autre implique des erreurs qui s’accumulent lors de la résolution d’équations complexes sur le comportement de l’air et de l’eau. La dernière erreur est de supposer qu’une température moyenne mondiale est une bonne mesure du changement climatique.

Je détaille ces erreurs dans mon article « A Nobel Prize for Climate Modeling Errors » (Un prix Nobel pour les erreurs de modélisation climatique), Science of Climate Change 4(1) pp. 1-73 (2024). Les références à des sections spécifiques de cet article, identifiées par C24, sont fournies dans la discussion.

Les trois premières erreurs dans la simplification du transfert d’énergie proviennent de l’article de Manabe et Wetherald publié en 1967, intitulé « Thermal equilibrium of the atmosphere with a given distribution of relative humidity » [MW67].

Dans cet article, ils ont utilisé un modèle radiatif-convectif unidimensionnel (1-D RC) avec une colonne d’air en état stationnaire et une distribution fixe de l’humidité relative (voir C24, section 3.1).

1) L’hypothèse d’un état stationnaire crée artificiellement dans le calcul un réchauffement avec l’augmentation des niveaux de CO2.

2) L’hypothèse d’une humidité relative fixe conduit à une « rétroaction de la vapeur d’eau » qui amplifie cet artefact de réchauffement initial.

3) Leur méthode d’intégration temporelle permet à de minuscules augmentations de température de s’accumuler au fil du temps, ce qui ne se produirait pas dans l’atmosphère réelle, car ces petits changements sont masqués par les variations normales des températures sur 24 heures ou sur l’année.

Lorsque MW67 double la concentration de CO2 de 300 à 600 ppm, ces erreurs de modélisation amènent une augmentation de la température de surface de 2,9 °C par ciel clair et de 2,4 °C pour une couverture nuageuse moyenne. Cette erreur a jeté les bases de la fraude climatique massive que nous connaissons aujourd’hui.

Les affirmations sur le réchauffement climatique étant devenues une source lucrative de financement de la recherche, il n’y avait plus de retour en arrière possible. À partir de ce moment, tous les modèles climatiques devaient montrer un réchauffement similaire pour un « doublement du CO2 ». Aujourd’hui, ce phénomène est connu sous le nom de sensibilité climatique à l’équilibre (ECS).

Manabe et Wetherald ont passé les huit années suivantes à intégrer les erreurs de leur modèle de 1967 dans un « modèle de circulation générale » (GCM, General Circulation Model) « hautement simplifié » [MW75]. Ce nouveau modèle a une ECS de 2,9 °C, contre 2,4 °C avec une couverture nuageuse moyenne dans MW67. MW75 a établi la référence en matière de réchauffement pour les futurs GCM climatiques.

Manabe et Stouffer ont introduit la quatrième erreur en 1979 avec leur algorithme représentant l’océan comme une dalle ou une plaque [d’épaisseur 68 m]. Ils ont négligé la manière dont l’énergie est transférée à la surface, ce qui conduit leur modèle océanique à se réchauffer en raison de l’augmentation du CO2 atmosphérique. Lorsqu’ils ont quadruplé les niveaux de CO2 de 300 à 1 200 ppm, cela a provoqué un artefact de réchauffement de la surface de 4,1 °C.

Le transfert de chaleur le plus important et variable venant de l’évaporation due au vent a éclipsé le rayonnement infrarouge thermique [dit à ondes longues LWIR] qui pénètre à moins de 100 microns dans la surface de l’océan. La faible augmentation du flux LWIR descendant due au CO2 n’était pas suffisante pour augmenter de manière significative les températures de surface de l’océan (voir C24, section 4.3).

Des événements extérieurs ont également commencé à influencer le développement des modèles climatiques. Alors que le programme Apollo (alunissage) touchait à sa fin en 1972, il y a eu un « glissement de mission ». Le groupe chargé de l’atmosphère planétaire à la NASA, dont faisait partie le jeune James Hansen, a reçu pour instruction de se tourner vers des applications terrestres (Hansen et al, 2000 (chapitre 4)).

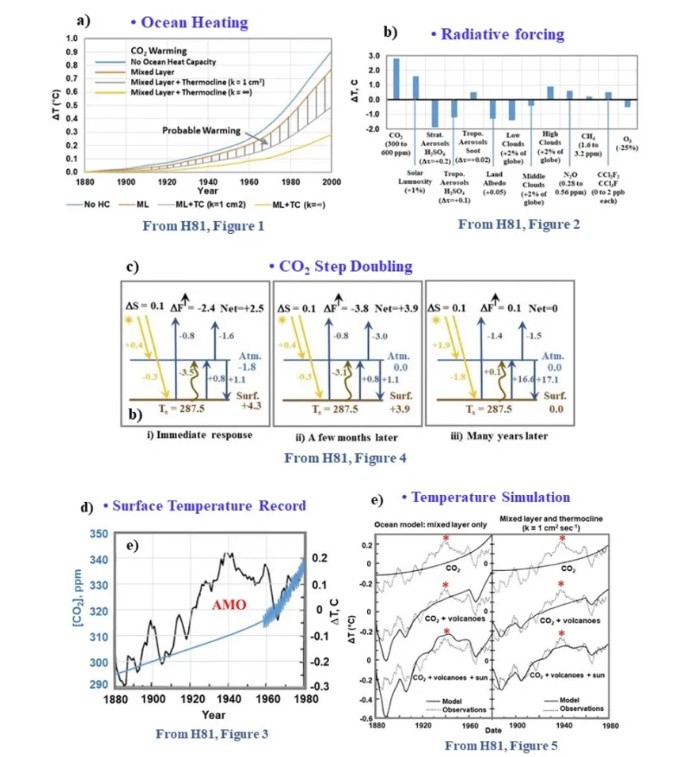

En 1976, ils ont copié le modèle MW67 1-D RC pour la « nébulosité moyenne » et ont créé des artefacts de réchauffement pour dix espèces mineures, dont le méthane (CH4) et l’oxyde nitreux (N2O) (Wang et al, 1976). Puis, en 1981, ils ont ajouté un modèle océanique à deux couches à leur version du MW67 (Hansen et al, 1981 (H81)).

À l’aide des stations météorologiques disponibles et des données connexes, ils ont fabriqué une série historique de valeurs de la température moyenne mondiale. Cependant, ils ont dans leur série historique de températures ignoré le pic, pourtant évident vers 1940, pic dû à la phase de réchauffement de l’oscillation multi-décennale atlantique (AMO).

En ajustant la concentration de CO2, l’intensité solaire et l’effet des aérosols volcaniques au fil du temps, ils ont pu « affiner » leur modèle RC 1-D modifié afin d’obtenir un résultat ressemblant à leur série historique des « températures moyennes mondiales ».

H81 a jeté les bases de la pseudoscience des forçages radiatifs, des rétroactions et de la sensibilité climatique que l’on retrouve encore aujourd’hui dans les modèles climatiques. Ceci est illustré par la figure 1 (voir C24, sections 3.3 et 4.5).

H81 a supposé que les changements de température créés par les artefacts mathématiques dans un modèle climatique de type RC 1D étaient réels et qu’un ajustement artificiel à la série historique de la température moyenne mondiale était en quelque sorte une mesure du changement climatique.

La température est une propriété thermodynamique intensive, et les moyennes de température sur des systèmes thermodynamiques indépendants ne sont que des chiffres sans signification physique (Essex et al, 2006). Le changement climatique devrait être défini en termes de changements des limites des zones climatiques, telles que celles utilisées dans la classification de Köppen ou dans des classifications connexes (Kottek et al, 2006) (voir C24, section 5).

À mesure que le financement des programmes nucléaires diminuait, la dérive des missions s’est étendue à la Commission de l’énergie atomique, qui avait en 1977 rejoint le ministère américain de l’Énergie (DOE). Le programme de recherche climatique du DOE s’est concentré sur la comparaison des modèles, dans le cadre de laquelle les chercheurs comparent les résultats de modèles imparfaits sans tenir compte de la réalité physique.

Le programme CMIP (Coupled Model Intercomparison Program) a débuté en 1996 (Meehl et al, 1997). Les différentes phases de ce programme ont fourni une grande partie des résultats climatiques douteux utilisés par le Groupe intergouvernemental sur l’évolution du climat (IPCC, PGIEC) des Nations unies (Stouffer et al, 2017, Hausfather, 2019).

À mesure que la technologie informatique s’est améliorée, les modèles climatiques sont devenus plus complexes. Les chercheurs ont ajouté davantage d’agents de forçage et ajusté les changements au fil du temps afin que les enregistrements de la température moyenne mondiale générés par les modèles correspondent à ceux des données des stations météorologiques.

Les premiers modèles 1D ont été remplacés par des GCM (modèles de circulation générale) atmosphériques, suivis par des GCM à océan-atmosphère couplés. Aujourd’hui, les chercheurs développent des modèles exascale qui combinent des scénarios d’émissions avec des GCM. Cependant, tous ces modèles à grande échelle reposent sur les fondements erronés établis par MW67 et H81.

L’hypothèse d’un état stationnaire des modèles 1D a été remplacée par un bilan énergétique mondial fictif. Cette nouvelle hypothèse est que le forçage radiatif des gaz à effet de serre ou diminution du rayonnement infrarouge thermique (OLR, Outgoing Longwave Radiation) sortant du sommet de l’atmosphère (TOA) modifie le bilan énergétique de la Terre.

Selon cette hypothèse, la température de surface augmenterait jusqu’à ce que l’équilibre du flux au sommet de l’atmosphère soit rétabli (Knutti et Hegerl, 2008). Au lieu de cela, la petite quantité de chaleur supplémentaire libérée dans la troposphère est renvoyée dans l’espace sous forme d’émission d’infrarouge thermique LWIR à large bande, ce qui n’entraîne pratiquement aucun changement dans le bilan énergétique de la Terre (voir C24, section 4.1).

En outre, les GCM nécessitent la résolution d’un très grand nombre d’équations non linéaires couplées. Les erreurs associées à la résolution de ces équations augmentent avec le temps et peuvent devenir instables. Les modèles de prévision météorologique sont limités à des prévisions pour disons les prochains 12 jours. Les modèles climatiques GCM ne peuvent pas fournir des prévisions aux échelles de temps requises pour des études climatiques [Lorenz, 1963 ; 1973].

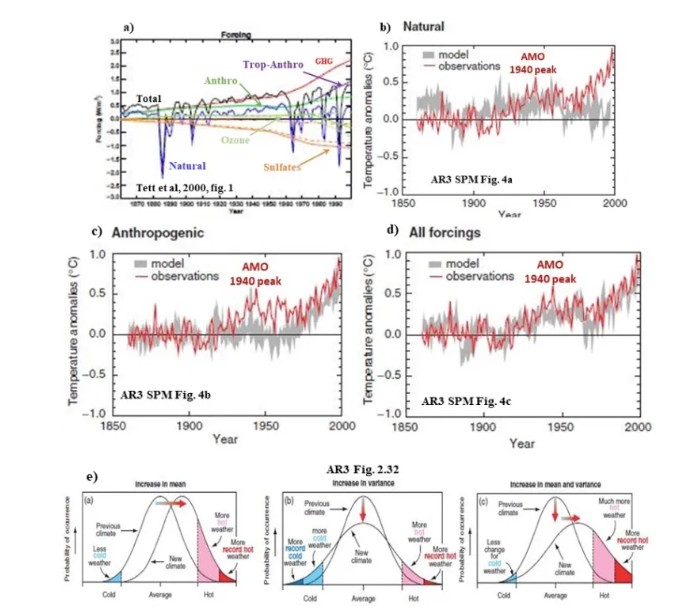

La cinquième erreur est apparue dans le troisième rapport d’évaluation du GIEC sur le climat (TAR) en 2001. Ce rapport a manipulé une série chronologique [ou « historique »] de forçages radiatifs pour créer l’illusion qu’elle correspondait aux données historiques sur la température moyenne mondiale.

Ce rapport a divisé ces forçages en contributions « naturelles » et contributions « anthropiques », comme le montre la figure 2a. Les chercheurs ont ensuite relancé les modèles climatiques pour générer des résultats distincts pour la « base de référence naturelle » et la « contribution anthropique », illustrés dans les figures 3b, 3c et 3d.

Un argument statistique vague, basé sur les changements de la distribution normale de la température, a relié les forçages « anthropiques » à l’augmentation de la fréquence et de l’intensité des « événements météorologiques extrêmes », comme le montre la figure 2e. La figure 2a est tirée de Tett et al, 2000. Les figures 2b à 2e sont tirées du TAR (l’AR3 est utilisé à la place du TAR dans la figure 3). Ce rapport a ignoré le pic évident des années 1940 lié aux phases de réchauffement de l’AMO.

Cette « attribution des phénomènes météorologiques extrêmes » a fourni une justification pseudoscientifique au contrôle politique de la combustion des combustibles fossiles, conduisant à la politique problématique du zéro net à laquelle nous sommes confrontés aujourd’hui (voir C24, section 3.5).

Divers groupes politiques et environnementaux ont commencé à exploiter les artefacts de réchauffement créés par les modèles climatiques pour faire avancer leurs programmes politiques. Un événement clé a été la conférence de 1975 intitulée « The Atmosphere Endangered and Endangering » (L’atmosphère en danger et menaçante), organisée par l’anthropologue Margaret Mead (Hecht, 2007). L’objectif de M. Mead était d’utiliser la pollution atmosphérique, réelle ou imaginaire, pour justifier le contrôle des naissances et limiter la croissance démographique.

Le GIEC a été créé en 1988, et le Programme américain de recherche sur le changement global (USGCRP) a été créé à l’initiative du président des USA en 1989 et mandaté par le Congrès en 1990. Le Hadley Climate Centre au Royaume-Uni a également été fondé en 1990.

La mission du GIEC est « d’évaluer les informations scientifiques, techniques et socio-économiques pertinentes pour la compréhension atmosphérique du risque de changement climatique induit par l’homme». Cette mission repose sur l’hypothèse que les activités humaines sont à l’origine d’un réchauffement climatique par le CO2.

L’USGCRP vise à « coordonner la recherche et les investissements fédéraux afin de comprendre les forces qui façonnent l’environnement mondial, tant humaines que naturelles, et leurs impacts sur la société ». Cependant, il n’a pas réussi à remplir cette mission car il a négligé les causes naturelles du changement climatique.

Les inondations, les sécheresses, les incendies de forêt et autres « phénomènes météorologiques extrêmes » résultent de conditions météorologiques naturelles, telles que des vents descendants, les dômes de haute pression et les oscillations océaniques, conditions météorologiques naturelles qui ne sont pas affectées par l’augmentation des concentrations de gaz à effet de serre (voir C24, sections 4.6 et 5.1).

L’USGCRP a accepté sans critique les méthodes pseudoscientifiques de modélisation climatique utilisées par le GIEC sans faire aucun effort pour valider indépendamment ces modèles.

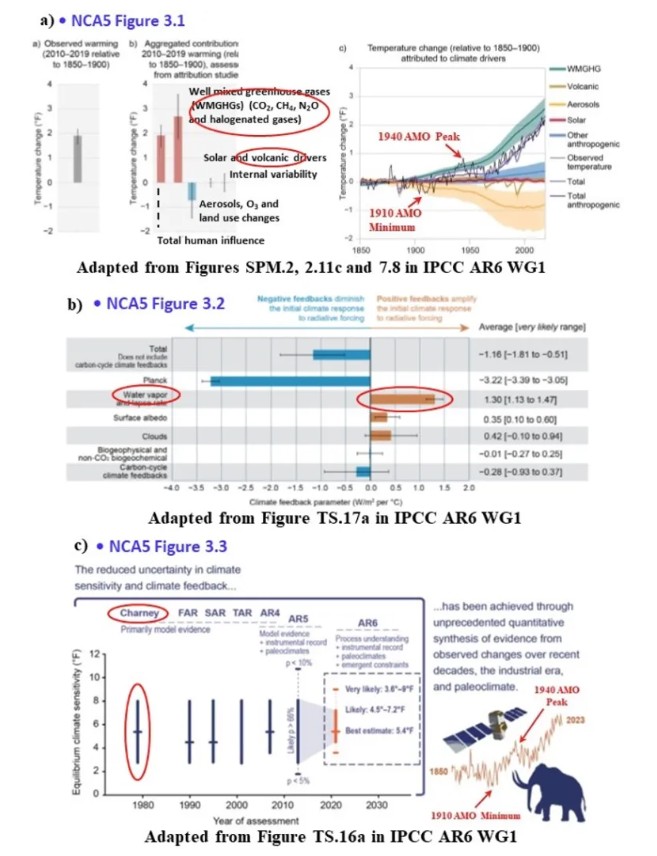

Le cinquième rapport national d’évaluation climatique (NCA5), publié par l’USGCRP en 2023, met en évidence le caractère pseudoscientifique de ses conclusions.

Les figures 3.1, 3.2 et 3.3 du chapitre 3, « Earth System Processes » (Processus du système terrestre), illustrent les forçages radiatifs, les rétroactions et les sensibilités climatiques utilisés dans les modèles climatiques qui justifient à tort les affirmations relatives aux conditions météorologiques extrêmes présentées dans le NCA5. Ces figures, adaptées du sixième rapport d’évaluation climatique du GIEC (AR6, 2021), apparaissent sous les numéros 3a, 3b et 3c.

La figure 3a retrace les « facteurs climatiques » en remontant dans le temps aux artefacts mathématiques des premiers modèles climatiques. MW67 a lancé le concept du réchauffement dû au CO2. Wang et al (1976) ont introduit les effets de réchauffement du CH4, du N2O et des gaz halogénés. H81 a utilisé les aérosols volcaniques pour « affiner » le modèle.

Le troisième rapport d’évaluation du GIEC sur le climat (2001) a mis l’accent sur l’influence humaine et son lien invalide avec des phénomènes météorologiques extrêmes. MW67 a également introduit la rétroaction de la vapeur d’eau illustrée à la figure 3b.

Pendant 200 ans, les scientifiques ont ignoré les travaux de Fourier sur le décalage temporel entre le pic du flux solaire et la réponse de la température de surface (Fourier, 1824). Ces variations quotidiennes et saisonnières montrent clairement une réponse thermique non équilibrée au flux solaire (Clark, 2023).

Nous devons considérer les changements de flux comme des changements dans la vitesse à laquelle un réservoir thermique se réchauffe ou se refroidit. (Clark et Rörsch, 2023). Le doublement de la concentration de CO2 de 300 à 600 ppm entraîne une augmentation du refroidissement de la troposphère par le rayonnement infrarouge thermique fourni au cosmos (LWIR) de +0,08 K par jour (Iacono et al, 2008).

Pour un gradient de température de -6,5 K km-1, une variation de +0,08 K équivaut à une diminution d’altitude de 12 mètres, soit environ l’équivalent d’une descente de quatre étages en ascenseur (voir C24, section 4.2).

Actuellement, l’augmentation annuelle moyenne du CO2 atmosphérique est d’environ 2,4 ppm, ce qui entraîne une augmentation de 34 milliwatts par mètre carré du flux infrarouge thermique LWIR descendant de la basse troposphère vers la surface. Ce changement est trop faible pour être mesuré par rapport aux variations quotidiennes normales de température et d’humidité. Il ne peut pas avoir d’incidence sur les phénomènes météorologiques extrêmes, ce qui signifie qu’il n’y a pas de « signal CO2 » détectable dans les archives climatiques (voir CR24, section 4.5).

La communauté des modélisateurs climatiques n’a pas réussi à corriger les erreurs de ses modèles. Les modélisateurs climatiques, qui sont davantage des mathématiciens appliqués et des programmeurs informatiques que des scientifiques, se concentrent sur la résolution d’équations complexes et la sécurisation de leurs salaires.

Ils ont ignoré les erreurs fondamentales de leurs modèles. Les minuscules changements de température et d’humidité prévus par ces modèles ne peuvent, dans le monde réel, pas s’accumuler au fil du temps.

Le réchauffement supposé induit par les gaz à effet de serre et la rétroaction de la vapeur d’eau ne sont que des artefacts mathématiques issus des hypothèses simplificatrices des modèles, établies avant même que le moindre code informatique ne soit écrit.

Tout modèle climatique dont la sensibilité climatique à l’équilibre est supérieure à « trop faible pour être mesurée » est intrinsèquement frauduleux. Il n’est pas nécessaire de poursuivre l’enquête.

La modélisation climatique est passée d’une recherche scientifique à ce qui ressemble à un culte impérial de l’apocalypse du réchauffement climatique. [Imperial Cult of the Global Warming Apocalypse]. La croyance dans les résultats des modèles a remplacé le raisonnement fondé sur des preuves. Les modélisateurs climatiques sont devenus les prophètes de ce Culte.

La fraude dans la modélisation climatique est évidente dans la littérature. Ces questions ne sont pas scientifiques, mais nécessitent des mesures politiques et juridiques pour résoudre les nombreux problèmes.

Roy Clark est un ingénieur à la retraite qui a plus de 40 ans d’expérience dans l’optique, la spectroscopie et le développement de nouveaux produits.

Quand on pourra présenter ce type de démonstration en étant un peu plus « vulgarisateur », l’imposture climatique apparaitra dans toute sa splendeur. Le vent tourne au USA; il tournera ici aussi. Patience!

il n’y a malheureusement pas que dans le domaine du climat que la science est en train de se discréditer.

A propos du point 1 de Roy Clark qui est probablement le plus important, Manabe 1967 fait de la pseudoscience en ne respectant pas la méthode scientifique. Dans son papier de 1964, Manabe avait pourtant mis en évidence ce qui empêchait le calcul thermodynamique de l’effet de serre :

« The observed tropospheric lapse rate of temperature is approximately 6,5°C/km. The explanation for this fact is rather complicated. It is essencially the result of a balance between (a) the stabilizing effect of upward heat transport in moist and dry convection on both small and large scales and (b) the destbilizing effect of radiative transfer. »

Il passe par-dessus cette difficulté en 1967 au moyen d’une affirmation en contradiction frontale avec ce qu’il écrivait en 1964 et sans aucune justification :

« Free and forced convection, and mixing by the large-scale eddies, prevent the lapse rate from exceeding a critical lapse rate equal to 6.5C km-1. »

C’est cette contrainte injustifiée et irréaliste sur le gradient thermique qui va directement donner naissance à la notion absurde de forçage radiatif et au calcul de l’effet de serre dans les GCM.

@phi

En effet, la conduction radiative est un effet propre à l’air non nuageux, dû aux radiations fortement absorbables. Dans la troposphère inférieure chaque couche d’air horizontale ayant une épaisseur de l’ordre de 50 à 100 m émet les radiations fortement absorbables par la vapeur d’eau ou par CO2 avec une intensité voisine de celle qu’elles ont dans le rayonnement noir à la température moyenne de cette couche, et absorbe à peu près intégralement les mêmes radiations émises par les couches analogues qui l’encadrent : d’où évidemment un transfert vertical d’énergie de couche à couche, obéissant en gros aux lois de la conduction thermique moléculaire : flux de chaleur vers les températures décroissantes, c’est à dire vers le haut, proportionnel au gradient de température.

C’est la conduction radiative qui explique notamment la transmission à l’air du refroidissement nocturne du sol en l’absence de vent, le coefficient de conduction correspondant étant de l’ordre du dixième du coefficient moyen dû à la turbulence dynamique.

Dans la troposphère supérieure, il faut considérer des couches plus épaisses en raison de la décroissance de densité des absorbants, mais le phénomène existe jusqu’à la tropopause.

La décroissance de la température dans la troposphère (du sol jusqu’à la tropopause) à un taux moyen de l’ordre de 6.5°C par kilomètre est une observation globale et en conséquence le forçage radiatif vers le bas, attribué à un prétendu effet de serre, ne peut pas exister dans l’atmosphère terrestre.

Merci pour cet article excellent.

On pourrait le soigner dans les détails et lui ajouter quelques sujets importants, mais il constitue déjà une très bonne base d’argumentation.

Reste la difficulté de l’adapter à destination du grand public.

@jeanlouislegrand

En effet, le grand public, dont je fais partie, a parfois des opinions, dont il peut changer, mais le plus souvent des croyances ou des convictions, celles-ci plus difficiles à contrecarrer, surtout quand « l’apocalypse » les justifie.

Avec Jean-Louis Legrand, je suis d’accord sur la nécessité d’une adaptation pour un public intéressé même si ce n’est pas le « grand » public

Dommage seulement que le forçage radiatif dû à l’augmentation des concentrations de gaz à effet de serre est mesurable depuis longtemps. Voir par exemple Philipona, et al., Radiative forcing – measured at Earth’s surface – corroborate the increasing greenhouse effect, Geophysical Research Letters, 2004. https://doi.org/10.1029/2003GL018765

Pour ceux qui l’ignorent, « Geophysical Research Letters » est un vrai journal scientifique, pas comme d’autres.

Bah non, on ne mesure pas quelque chose qui n’existe pas, quelque chose d’absurde et qui contrevient aux lois de la thermodynamique. Ce que l’on peut mesurer, c’est l’irradiance de l’atmosphère.

C’est fou à quel point la pataphysique du climat se moque de la thermodynamique.

Phi. Quand même. Depuis l’espace, on mesure bien aussi l’effet de l’augmentation du CO2 sur le rayonnement infrarouge, en excellent accord avec les prédictions. Voir ici : « Direct observational evidence from space of the effect of CO2 increase on longwave spectral radiances: the unique role of high-spectral-resolution measurements », https://acp.copernicus.org/articles/24/6375/2024/

Posez-vous la question : Quelle observation me faudrait-il pour que j’accepte le consensus scientifique sur le sujet ? Si vous ne pouvez pas imaginer changer d’avis, vous êtes anti-scientifique. Par exemple, pour moi, c’est simple : il suffirait par exemple que la tendance de température (à l’échelle décennale) s’inverse (de faon non explicable… une grande éruption volcanique ne compterait évidemment pas) pour que je dise « OK, ils se sont trompés ». Bref, j’ai un avis qui peut être ébranlé par des faits contraires au consensus. Et vous ? Etes-vous ouvert à une révision de vos certitudes ou complètement obtus ?

Arsène,

Où avez-vous lu que je nierais l’éventuelle possibilité de détecter l’effet du CO2 sur l’irradiance de l’atmosphère ?

Vous avez prétendu que le forçage radiatif du CO2 était mesurable. Or, c’est idiot parce que cette notion de forçage radiatif n’a strictement aucun sens et ne peut donc être mesurée.

Je note en passant qu’une revue (Geophysical Research Letters) ose publier un papier intitulé « Radiative forcing – measured at Earth’s surface » ne la discrédite pas moins que si elle avait laissé passer quelque chose comme « Mesure de la densité de phlogistons dans les laitues romaines ».

Un peu plus haut sur ce fil, j’ai parlé de l’origine de ce fumeux forçage radiatif. A défaut de pouvoir mené un calcul thermodynamique de l’effet de serre, Manabe a posé, contre toute les connaissances solides acquises et sans justification, que le gradient thermique de la troposphère était indépendant des flux radiatifs. Conséquence remarquable : tout déséquilibre radiatif quelque soit son origine n’a que la translation du profil thermique pour se résorber. Altération du flux solaire ou modification de la structure radiative de l’atmosphère produisent donc les mêmes effets sur le système thermodynamique. La valeur du déséquilibre a été baptisé forçage radiatif. Exit les acquis de la thermodynamique et en particulier l’entropie (allez calculer la variation d’entropie liée à un forçage radiatif!).

Toute la problématique du RCA s’est construite sur cette désolante ânerie!

Bon, faut quand même dire que la science n’est qu’un verni très superficiel dans cette histoire hilarante et mystico-idéologique du climat.

@Arsène

Merci pour ce commentaire qui démontre l’obstination de certains à refuser la discussion scientifique honnête.

Vous citez un article de Philipona, et al., Radiative forcing – measured at Earth’ surface – corroborate the increasing greenhouse effect, 2004.

Sur le plan scientifique cet article commet au moins deux erreurs fondamentales :

1. Il utilise l’équation de Stefan-Boltzmann pour évaluer le rayonnement ondes longues descendant, ce qui supposerait d’avoir dans l’atmosphère une surface matérielle dont on connaîtrait la température et qui aurait une émittance vers le bas.

Or d’une part en physique atmosphérique une telle surface ne peut pas exister et d’autre par il ne peut pas y avoir d’émittance vers le bas parce que la physique interdit un flux de chaleur du froid vers le chaud.

2. Il prétend mesurer un forcing radiatif en surface, mais la physique ne le permet pas. Certes on peut mesurer un rayonnement ondes longues descendant, mais attribuer une partie de ce flux à un effet ou un autre n’est pas possible. La physique ne le permet pas. Donc attribuer une partie de ce rayonnement à un effet de serre résulte d’hypothèses et de calculs discutables et prétendre l’avoir mesuré est une tromperie délibérée.

La revue Geophysical Research letters est-elle une publication scientifique sérieuse ?

Vous trouverez à l’adresse suivante : https://agupubs.onlinelibrary.wiley.com/doi/10.1002/2015GL064696, un article de Yue, et al., intitulé Increasing carbon dioxide concentration in the upper atmosphere observed by SABER, 2015.

Dans cet article les auteurs prétendent : » La concordance entre SABER et ACE-FTS suggère que le taux d’augmentation du CO2 dans la haute atmosphère au cours des 13 dernières années est considérablement plus élevé que ne le permettent d’expliquer les modèles chimie-climat. « .

Or ce que les auteurs appellent la haute atmosphère se situe entre 80 et 100 km d’altitude. A ces altitudes on ne peut pas trouver de dioxyde de carbonne en raison de la gravité. Les cellules de dioxyde de carbonne ont un poids atomique pas très différent de celui de l’ozone stratosphérique et par conséquent au dessus de 50 km d’altitude on ne trouve plus aucune cellule, ni de l’un, ni de l’autre.

La conclusion est simple : l’article que vous citez en référence n’est pas un article scientifique sérieux et la revue qui l’a publié n’est pas une revue scientifique sérieuse.

On peut certainement discuter l’article de Roy Clark, mais il faut le faire avec une argumentation scientifique sérieuse et éviter de se référer à de vieux articles que plus personne n’oserait publier aujourd’hui.

Après les démonstrations de Dufresne avec sa plaque de verre sensée représenter l’atmosphère, ou bien l’analogie avec la toiture isolée d’un bâtiment, il ne faut plus s’étonner de rien.

Merci pour vos précisions pertinentes.

Bonjour,

Phi et vous n’avez toujours pas compris la différence entre un rayonnement et un flux net d’énergie. Dès qu’un corps (un ensemble de molécules) a une température supérieure au zéro absolu (donc toujours), ce corps émet un rayonnement thermique. Même s’il est plus froid que la matière qui l’entoure. Point.

Concernant Geophysical Research Letters : Le fait que vous ne connaissiez pas ce journal est une preuve de votre ignorance du monde scientifique.

Demandons par exemple à Le Chat (pour soutenir l’économie française… je suis assez certain que même Grok vous donnera une réponse similaire) :

Question : « Est-ce que Geophysical Research Letters peut être considéré comme un journal scientifique sérieux ? »

Réponse : « Oui, Geophysical Research Letters (GRL) est largement considéré comme un journal scientifique sérieux et de haute qualité. Voici les principaux points qui le confirment :

– Revue à comité de lecture : GRL est une revue bihebdomadaire évaluée par des pairs, publiée par l’American Geophysical Union (AGU), une institution reconnue dans le domaine des géosciences.

– Facteur d’impact élevé : En 2025, son facteur d’impact est d’environ 4,6 à 5,2, ce qui le place dans le premier quartile (Q1) des revues en sciences de la Terre et planétaires, un indicateur fort de son influence et de sa crédibilité scientifique.

– Reconnaissance internationale : GRL publie des recherches innovantes et à fort impact dans tous les domaines des géosciences, et ses articles sont largement cités dans la communauté scientifique.

– Absence de liste noire : Le journal n’est pas répertorié comme une revue prédatrice, ce qui confirme sa légitimité.

En résumé, Geophysical Research Letters est une référence dans le domaine des géosciences et peut être considéré comme un journal sérieux pour la publication et la consultation de recherches scientifiques. »

Question : « Est-ce que ‘Science of Climate Change’, édité par la ‘SCC Publishing association’, peut être considéré comme un journal scientifique sérieux ? »

Réponse: « Le journal ‘Science of Climate Change’, édité par la ‘SCC Publishing association’, ne peut pas être considéré comme un journal scientifique sérieux et reconnu au même titre que les grandes revues académiques en climatologie.

Voici les éléments à considérer :

– Absence d’indexation dans les grandes bases de données : Contrairement aux revues sérieuses comme Nature Climate Change, Geophysical Research Letters ou Climatic Change, « Science of Climate Change » n’est pas indexé dans les bases de données scientifiques majeures (Scopus, Web of Science, etc.) en 2025. Ces bases sont des indicateurs clés de la reconnaissance et de la qualité scientifique d’un journal.

– Positionnement éditorial particulier : Le journal se présente comme une plateforme pour des contributions scientifiques « alternatives » ou contradictoires avec le consensus climatique dominant, ce qui peut indiquer une orientation éditoriale plus militante que scientifique. Il publie aussi des essais, des comptes-rendus de conférences et des résumés de livres, ce qui n’est pas typique des revues scientifiques strictes.

– Manque de transparence et de reconnaissance : La « SCC Publishing association » n’est pas une maison d’édition scientifique reconnue internationalement, contrairement à des éditeurs comme Elsevier, Springer, ou l’American Geophysical Union.

– Historique controversé : Le journal a repris des publications d’une revue précédente (« Pattern Recognition in Physics ») qui avait été arrêtée par son éditeur pour des raisons liées à la qualité et à la rigueur scientifique.

En résumé, « Science of Climate Change » ne répond pas aux critères habituels de sérieux et de reconnaissance scientifique. Pour des recherches ou des publications en climatologie, il est préférable de privilégier des revues indexées et reconnues par la communauté scientifique internationale. »

Bien sûr, vous direz « IA », et vous avez raison dans le sens qu’une réponse d’un LLM ne suffit pas. Mais n’importe quelle personne honnête et dotée d’un minimum de connaissances scientifiques vous confirmera l’essentiel de la réponse « du Chat ».

PP, puisque vous pensez que GRL est nimp, lisez ça : « Observations of increasing carbon dioxide concentration in Earth’s thermosphere » – https://www.nature.com/articles/ngeo1626

Bien sûr, vous pouvez aussi dire que Nature Geoscience n’est pas un journal sérieux, puisque vous ne craignez pas le ridicule.

Bonjour Arsène,

L’article que vous citez : » Observations of increasing carbon dioxide concentration in Earth’s thermosphere » commet exactement la même erreur que celui que j’ai moi-même cité : » Increasing carbon dioxide concentration in the upper atmosphere observed by SABER « .

La preuve de cette erreur est facile à comprendre :

1. Le dioxyde de carbone a une certaine masse molaire 44,01 g/mol ce qui est la somme de deux masses molaires d’oxygène et une masse molaire de carbone. C’est proche de la masse molaire de l’ozone : 48 u, mais beaucoup plus lourd que l’azote : 14,01 u qui est proche de l’oxygène : 16 u.

2. La terre tourne sur elle même ce qui a pour effet que toute particule d’un certain poids est soumise à une force centrifuge orientée vers le cosmos.

3. La Terre a une masse telle que toute particule d’un certain poids est soumise à une force de gravité orientée vers le centre de la Terre.

4. L’altitude limite à laquelle on peut trouver des particules d’un poids donné est celle à laquelle la force centrifuge est équilibrée par la force de gravité.

5. Comme la masse molaire de l’ozone et du dioxyde de carbone sont proches, on peut faire l’hypothèse que l’altitude limite à laquelle on peut trouver du dioxyde de carbone est proche de celle de l’ozone qui est de l’ordre de 50 km d’altitude, très en dessous de la thermosphère.

6. On connaît la composition de la thermosphère qui se trouve au dessus de 95 km d’altitude : oxygène atomique, azote atomique et hélium qui ont chacun une masse molaire beaucoup plus faible que celle du dioxyde de carbone ou de l’ozone.

C’est cohérent avec ce que je dis : on ne peut pas trouver de dioxyde de carbone aux altitudes étudiées dans ces articles en raison de son poids molaire.

Ces articles ne sont pas sérieux et les revues qui les ont publiées non plus parce que ce que je dis est très simple à comprendre et les reviewers, s’ils existent, n’auraient jamais dû laisser publier ces articles.

Je pense que l’erreur commise par les auteurs de ces deux article résulte du fait qu’à ces hautes altitudes de l’atmosphère il peut y avoir du dioxyde (O2) qui est dissocié en O par le soleil.

Je vous laisse méditer sur mes explications et choisir de quel côté se trouve le ridicule.

En ce qui concerne le premier paragraphe de votre réponse, je vous indique que l’atmosphère ou une partie de celle-ci n’est pas un » corps » au sens physique du terme et aucun corps n’émet un flux thermique du froid vers le chaud, cela violerait le premier principe de la thermodynamique.

PP, retournez au lycée. La force centrifuge et la force d’attraction gravitationnelle sont toutes les deux proportionnelles à la masse. Les particules lourdes ne sont pas plus facilement « éjectées » vers l’espace.

Les raisons principales de la raréfaction de l’ozone au-delà de 50 km d’altitude sont le rayonnement UV intense (photodissociation) et une faible densité de l’air.

C’est quand même dingue. Vous avez une idée préconçue complètement aberrante et sur la base de ce demi-savoir erroné, vous êtes complètement aveugle aux faits. Faites une petite recherche dans Google Scholar (par exemple avec les mots clefs « CO2 concentration mesosphere observations »), et vous serez inondée d’articles qui vous donnent des mesures de la concentration de CO2 dans la mésosphère (environ 100 km), de l’ordre de 250-300 ppm.

Par exemple Qian et al., « Carbon dioxide trends in the mesosphere and lower thermosphere », JGR Space Physics, 2017, https://agupubs.onlinelibrary.wiley.com/doi/full/10.1002/2016JA023825

Posez-vous au moins la question de savoir d’où vient votre idée absurde sur l’éjection des molécules lourdes par la force centrifuge. Trouvez la source. Et posez-vous honnêtement la question si votre source est fiable, si ce n’est votre propre imagination fertile.

PP, j’ai relu votre réponse parce que c’est un tel concentré de non-sens que je ne sais pas s’il faut rire ou pleurer.

Je cite : « A ces altitudes on ne peut pas trouver de dioxyde de carbonne en raison de la gravité. Les cellules de dioxyde de carbonne ont un poids atomique pas très différent de celui de l’ozone stratosphérique et par conséquent au dessus de 50 km d’altitude on ne trouve plus aucune cellule, ni de l’un, ni de l’autre. »

– Vous voulez dire que les moélcules de O3 et de CO2 sont beaucoup plus lourdes que celles du N2, c’est ça ? Vous ne dites pas ça mais j’imagine que c’est ça votre idée. Bref, vous imaginez la mésosphère un peu comme le tombeau du pharaon, où le CO2 s’accumule gentiment près de sol pendant des siècles. Vu dans Tintin, hein ? Les vitesses du vent typiques dans la mésosphère sont de l’ordre de plusieurs centaines de km/h. Si vous arrivez à faire un tassement gravitationnel parfait dans une telle atmosphère, chapeau ! En fait, il y a de la photodissociation qui fait que la concentration en altitude est plus faible qu’à la surface, mais elle reste de l’ordre de 200 ppm (voir http://dx.doi.org/10.1038/ngeo1626).

Bref, soignez votre hygiène intellectuelle, arrêtez de vous informer dans les poubelles.

Si Roy Clark avait un seul argument valable, il serait en piste pour le prochain Prix Nobel de Physique, car une réfutation des résultats scientifiques qui ont mené à un Prix Nobel (ici, celui de Manabe et Hasselmann), ça vaut bien un Nobel. En tout cas, je ne crois pas que ça c’est déjà vu.

Qui est prêt à parier avec moi que Roy Clark n’aura pas le Prix Nobel de Physique pour son torchon ? Je serais prêt à parier une belle somme. On dit 10000 € ?

Et voilà , après s’être fait dézingué par ailleurs , suivi une digestion lente , revoici le troll « Lupin » avec une argumentation d’une pauvreté abyssale, un suivisme de marionnette .

Le « point » d’autorité , c’est votre virgule en signature , un développement plus que court et donc une incapacité de contrer honnêtement semble t il et donc on dérive sur l’insulte en abusant de réf payante de 13 ans d’âge ( honte de rien ) . La Défense ? ; le venin en un comportement de « branleur » de recrée dans son retranchement.

Pauvre France de la science encartée en mode œillère et pas que ….. Alors que les caisses sont vides , après avoir tué la filiaire nuk , on dépense des milliards dans le vent de l’éolien littoral pour un gain marginal et tout ceci avec bénédiction de l’incompétence crasse des copains et des coquins d’une gauche en perdition dont a une époque j’y faisais corps. Je prie pour que cette prédication cesse ; Arsène vous êtes Bernard Gui ( Nobel du pape) dans l’inquisition d’Umberto Eco , à griller le coupable facile du cellerier Rémigio ; Roy Clark au bûcher

pauvre de vous !

Des molécules de gaz quittent la Terre tous les jours, certes d’autant moins qu’elles sont plus lourdes. La cinétiques des gaz nous dit que les molécules sont animées d’une vitesse moyenne statistique constante qui ne dépend que de la température. A 30km d’altitude une molécule H2 aura une vitesse moyenne d’environ 1600m/s tandis qu’une molécule de C2 ce sera env 420m/s. « L’équilibre dynamique » doit tenir compte de cette énergie cinétique. Le lien suivant est très intéressant :

https://ipag.osug.fr/~beckp/Research/Teaching_files/M2R_Planeto_cours2.pdf

Oui, il serait bien d’avoir une vulgarisation de l’article à destination du « servum pecus » (dont je suis)…

Mais ce que je retiens de tout ça, c’est l’impression d’une immense tambouille politico-pseudo-scientifique où l’on enlève un peu de ceci, où l’on rajoute un peu de cela dans ses calculs de « modèles » pour, à l’arrivée, tenter de se retrouver (mal) en phase avec la réalité des observations du terrain, les politiciens écolos et leurs affidés tirant les ficelles en amont (les « chercheurs » devant leur manger dans la main pour obtenir des aides substantielles) et recueillant les marrons du feu en aval (pour justifier « scientifiquement » leur idéologie nourrie de l’exploitation de la « Grande Peur »).

Mais quand bien même les « modèles » correspondraient à l’observation sur le terrain (ce qui est loin d’être le cas), cela ne signifierait pas que les modèles disent ce qui est.

Je repense toujours à Einstein et son histoire de montre : »Les concepts physiques sont des créations libres de l’esprit humain et ne sont pas, comme on pourrait le croire, uniquement déterminés par le monde extérieur. Dans l’effort que nous faisons pour comprendre le monde, nous ressemblons quelque peu à l’homme qui essaie de comprendre le mécanisme d’une montre fermée. Il voit le cadran et les aiguilles en mouvement, il entend le tic-tac, mais il n’a aucun moyen d’ouvrir le boîtier. S’il est ingénieux il pourra se former quelque image du mécanisme, qu’il rendra responsable de tout ce qu’il observe, mais il ne sera jamais sûr que son image soit la seule capable d’expliquer ses observations. Il ne sera jamais en état de comparer son image avec le mécanisme réel, et il ne peut même pas se représenter la possibilité ou la signification d’une telle comparaison. Mais le chercheur croit certainement qu’à mesure que ses connaissances s’accroîtront, son image de la réalité deviendra de plus en plus simple et expliquera des domaines de plus en plus étendus de ses impressions sensibles. Il pourra aussi croire à l’existence d’une limite idéale de la connaissance que l’esprit humain peut atteindre. Il pourra appeler cette limite idéale la vérité objective. »

Ce qui n’est rien d’autre que la version einsteinienne de l’idéalisme kantien : on n’en a pas fini avec les grands penseurs de notre histoire qui savaient relativiser (c’est le cas de le dire) leurs propres recherches et garder une vue d’ensemble (métaphysique) des problèmes, loin de la myopie qui caractérise notre époque et ses « chercheurs » tellement spécialisés dans leur petit domaine qu’ils peuvent devenir aisément l’objet, volens nolens, de toutes les manipulations possibles, notamment politiques, quand ils ne sont pas eux-mêmes de fervents militants vendant leur « savoir » à leur idéologie…

La science ne pense pas.

A méditer, peut-être…

Bonjour Lucien,

Je crois utile de donner des explications » grand public » sur la discussion initiée par phi, que j’ai soutenu en apportant ma contribution, ce qui a déclenché l’intervention injurieuse d’Arsène.

1. L’article de Roy Clark est une critique de » l’effet de serre » vu par les américains, c’est à dire principalement par la NASA et la NOAA, qui reposait principalement sur l’analyse du bilan radiatif ;

2. En France » l’effet de serre » est vu comme l’effet d’un » flux thermique vers le bas depuis la tropopause vers la surface de la Terre (je me réfère à un cours du Collège de France). Ceci repose sur deux idées fausses : Il faut qu’il y ait du CO2 dans la haute atmosphère et il faut qu’il y ait une surface matérielle dans l’atmosphère qui émette un flux de chaleur vers le bas pour réchauffer la surface de la Terre. D’autres scientifiques et moi avons dit que les lois de la physique ne permettaient pas cette explication ;

3. Dans mon intervention ci-dessus j’ai utilisé l’argument de la gravité qui empêche que le CO2, en raison de son poids molaire puisse parvenir à une altitude de 100 km, mais j’aurai pu utiliser l’argument de la densité de l’air à cette altitude : vous pouvez visiter le site de l’Institut royal d’Aéronomie spatiale de Belgique https://www.aeronomie.be/fr/encyclopedie/densite-latmosphere-diminue-avec-laltitude où vous pourrez lire :

a) » La densité de l’atmosphère diminue de façon exponentielle avec l’altitude, ce qui signifie que le nombre de molécules de gaz que l’on trouve dans un mètre cube diminue d’un million entre la surface et 100 km d’altitude. »

Donc à supposer qu’il y ait du CO2 à 100 km d’altitude, cela a-t-il un sens physique de mesurer un rapport de mélange et prétendre qu’il est de 200 ppm ?

b) » Dans l’atmosphère moyenne (stratosphère et mésosphère, entre 15 et 100 km d’altitude), la chimie devient plus simple, car les molécules organiques complexes sont brisées en plus petits morceaux avant d’atteindre cette altitude.

Les molécules sont beaucoup plus dispersées, elles entrent en collision et interagissent beaucoup moins. Par conséquent, il n’y a pas d’équilibre thermique dans la mésosphère : différents gaz peuvent avoir des températures différentes, car les molécules sont beaucoup plus isolées (on pourrait dire qu’elles pratiquent la distanciation sociale) et ne peuvent pas échanger efficacement la chaleur. « .

Donc il est clair qu’il ne peut pas y avoir de CO2 à 100 km d’altitude.

4. Comme l’a noté Dany l’article cité par Arsène date de 2012 et il est cité par l’article que j’ai mentionné qui date de 2013. Par acquis de conscience j’ai consulté plusieurs articles cités en référence dans l’article de 2013 et il est vrai qu’on trouve des » observations de CO2 » à 100 km dans plusieurs articles, mais ce sont toutes des observations par satellites qui sont sujettes et caution et dans ce cas précis manifestement erronées pour les raisons que j’ai dit plus haut.

5. Ce qu’il faut savoir sur la mesure du CO2 dans l’atmosphère : on peut faire une mesure directe du CO2 avec des sondes portées par des ballons stratosphérique qui peuvent monter jusqu’à une altitude de 35 km au mieux. Au dessus de cette altitude on ne peut faire que des mesures par satellites ce qui suppose d’avoir un capteur adapté et avoir un modèle physique qui interprète ce que reçoit le capteur. Naturellement il faut calibrer l’instrument et le modèle physique, ce qui n’est pas simple et les causes possibles d’erreurs sont multiples.

6. Malgré une recherche intensive, je n’ai pas trouvé d’article récent, c’est à dire postérieur à 2013, mentionnant la présence de CO2 à 100 km. Par contre, j’ai trouvé un article mentionnant une erreur sur la mesure de la vapeur d’eau par SABER à cette altitude qui a été corrigée.

Donc les erreurs sont possibles et sont corrigées quand les chercheurs qui utilisent les données constatent des anomalies. On peut en conclure comme je le dis depuis le début de cette discussion que trouver du CO2 à 100 km d’altitude est une anomalie que ni les scientifiques qui ont utilisées les données de SABER, ni les reviewers supposés avoir contrôlé les articles, ni les éditeurs de revues ne se sont inquiétés de cette anomalie, ce qui est plus qu’inquiétant pour la sciences.

7. Ce que l’on peut conclure de cette histoire, c’est que certains ont intérêt à manipuler la science pour des raisons que je ne discuterai pas ici, mais il est sain que ceux qui peuvent mettre en évidence les erreurs commises par certains scientifiques douteux dans le domaine de » l’effet de serre » le fassent sans se faire insulter.

Bonjour PP,

Si vous ne cherchez que dans les poubelles où vous avez visiblement l’habitude de vous servir, il est certain que vous ne trouverez pas grand-chose.

Essayez Google Scholar. Mots clefs : « CO2 concentration observ* mesosphere ». Limiter la recherche à la période postérieure à 2013. Vous trouverez beaucoup de résultats en 3 secondes.

Incroyable… on se croirait chez les barbares de la pire espèce, et on n’y porte même plus attention : on se fait à l’ignoble…

Comme quoi la science n’est vraiment pas synonyme d’intelligence !

Je crois ici que PP s’adressait à moi, non ?

Sinon, c’est votre façon habituelle de vous adresser aux gens, Arsène, avec condescendance et grossièreté, ou c’est une technique bien éprouvée de bon militant « écolo-gaucho » pour déstabiliser l’adversaire et le pousser dans ses derniers retranchements, sans avoir à aborder le fond ?

Ou peut-être est-ce les deux ?

Le « Lupin », lui, était un gentleman : vous portez vraiment bien mal votre pseudo…

En tout cas on ne reconnait pas là les propos d’un savant digne de ce nom et sûr de sa science : la peur (d’avoir tort) peut rendre effectivement très agressif…

La seule attitude à adopter face à votre niveau de « sous-humanité » (l’humain se caractérise par l’empathie et l’affabilité, quand bien même l’adversaire serait dans l’erreur, j’allais dire surtout si le contradicteur est dans l’erreur), est le mépris… pffffffffff…

Cher Lucien,

« Sans aborder le fond » ? Je pense être le seul ici à aborder le fond, malheureusement. Cherchez les arguments pour me contredire sur les faits chez vos amis, vous n’en trouverez pas (sauf chez Jack qui nous envoie une vidéo des années 60 qui ne dit pas ce que l’IA veut lui faire dire !).

Bonjour Arsène,

– « Je pense être le seul à aborder le fond », dites-vous : ceci est évidemment faux : que les arguments adverses vous paraissent faibles (ou inexacts) ne signifie pas qu’il ne s’agisse là d’ »arguments » : PP et Phi argumentent, ne vous en déplaise, et ils ne sont de plus pas « mes amis »…

– Si vraiment « le fond » était votre souci il n’y aurait pas besoin de rajouter des propos injurieux du genre : « Bref, soignez votre hygiène intellectuelle, arrêtez de vous informer dans les poubelles », ou plus loin : « Si vous ne cherchez que dans les poubelles où vous avez visiblement l’habitude de vous servir etc. », (« bis repetita placent », dirait Rémy Prud’homme) et autres amabilités qui n’ont vraiment rien de « scientifiques » et n’ont pas leur place dans un débat intellectuel, entre gens éduqués et prétendument cultivés.

– Car évidemment là n’est pas le « fond » du problème : le fond est politique et uniquement po-li-ti-que, et vos propos le révèlent à votre insu…

– Le simple fait que vous parliez de « mes amis » en désignant par cette expression Phi et PP (entre autres) impliquent que vous les considériez, par déduction logique, comme « vos ennemis »… or il n’y a pas d’ « amis », ni d’ « ennemis » en science, mais seulement des « contradicteurs » ou éventuellement des « rivaux », voire des « opposants »… La désignation d’un « ami », et par conséquence logique d’un « ennemi » (« inimicus » privé qui devient un « hostis » public politique) signifie ipso facto que vous êtes rentré dans le domaine du politique sans vous en être aperçu, car le problème de l’écologisme (c’est-à-dire de l’écologie politique) relève autant du scientifique que de la linguistique, de la rhétorique (et là-dessus Aristote aurait sans doute beaucoup à vous apprendre) et du politique… Et c’est dans le champ politique, c’est-à-dire du conflit par excellence, que la polémique est omniprésente, et c’est pourquoi vos propos comme ceux de vos « amis » (et j’emploie ici le mot « amis » à dessein) sont naturellement polémiques, non pas de manière conjoncturelle mais structurelle.

– L’enjeu écologiste est politique, se chiffre par centaines de milliards, et détermine toute la politique énergétique à venir de l’Europe, de l’Occident de manière générale (nonobstant l’intermède Trump, qui n’aura qu’un bref temps), et par voie de conséquence du monde entier, via l’ONU et son « Programme des Nations Unies pour l’Environnement » (PNUE) créé en 1972. Le lobbying écologiste au sein de l’Europe est le plus militant de tous depuis de nombreuses années, et a atteint son paroxysme sous la présidence de von der Layen : il importe donc d’éteindre toute opposition dans l’œuf au plus vite en parlant précipitamment de « consensus scientifique »… qui n’existe toujours pas (car il exigerait l’unanimité des voix de tous les savants du domaine scientifique), sauf à le confondre précisément avec un « consensus politique » qui ne requiert que la grande majorité des voix (autre confusion intéressante à noter)… mais la science n’est pas la politique, ni la démocratie : un seul peut avoir raison contre tous.

– Lorsque vous interrogez « Le Chat » sur : «Est-ce que ‘Science of Climate Change’, édité par la ‘SCC Publishing association’, peut être considéré comme un journal scientifique sérieux ? », l’une des réponses que vous rapportez est : « Positionnement éditorial particulier : Le journal se présente comme une plateforme pour des contributions scientifiques « alternatives » ou contradictoires avec le consensus climatique dominant, ce qui peut indiquer une orientation éditoriale plus militante que scientifique. ». Autrement dit vous interrogez l’I.A., biberonnée au discours écologiste dominant, sur la scientificité d’une revue qui met en cause ce même discours dominant : sans jeu de mots, je dirai que « Le Chat se mord la queue » !

– Peut-être n’avez-vous pas compris, cher Arsène, que « l’Intelligence Artificielle » n’est justement pas « intelligente » au sens de « l’intelligence humaine », mais qu’il s’agit là d’une analogie (on en revient à la rhétorique : l’IA est à l’ordinateur ce que l’intelligence humaine est à l’homme, autrement dit : 4/2 = 1000/500… et pourtant 4 n’est pas égale à 1000), l’IA ne peut régurgiter que ce qu’on lui met dans les circuits, contrairement à l’intelligence humaine qui justement peut « casser les codes », même si cette dernière calcule infiniment moins vite que l’IA… et je croyais justement que le propre d’une « vérité scientifique » était de toujours pouvoir être mise en cause, et qu’elle n’était une « vérité » que pour autant qu’elle fût « falsifiable » (anglicisme qui signifie : « rendue fausse » par une démonstration « contradictoire ») : je crains, en l’occurrence, que ce ne soit « le consensus scientifique dominant » (expression autoritaire et qui sonne bien peu « scientifique ») qui ne relève de la croyance dogmatique et d’une « orientation toute militante »…

– Car la « science » au sens où vous l’entendez est uniquement un enjeu de pouvoir où les dominants doivent écraser les dominés et les faire taire, où l’amour-propre du « chercheur » peut s’exercer sans retenue et lui permettre d’affirmer son ego et d’humilier son adversaire, jusqu’à l’achever à terre… les chiens sont lâchés, c’est la curée, car la politique a tout dévoré sous sa forme la plus achevée : la guerre de tous contre tous, ou plutôt celle des Bons « écolos » contre les Méchants « réalistes », les bolcheviques contre les mencheviques, celle de la terrible « justa causa » qui justifie tous les génocides et les réductions au silence puisque l’adversaire n’est pas, ou n’est plus un humain…

– L’origine du conflit entre écolos et anti-écolos, droite et gauche (« réchauffistes » et « réalistes », en termes climatiques), n’est bien entendu pas scientifique : il n’y a pas de guerre scientifique, ni religieuse, ni économique, ni culturelle etc. : la guerre est toujours politique (« la politique continuée par d’autres moyens »)…

– Le politique est toujours le prérequis à toute guerre, comme l’étincelle enflamme la paille avant que le feu ne dévore tout sur son passage, en fasse son combustible quelle qu’en soit la nature (bois, essence, plâtre, câbles électriques, métaux, etc.), l’unifie sous sa flamme dévorante pour continuer à se propager partout… et il y a longtemps que Polemos a enflammé l’écologie scientifique pour la muter en simple carburant, en « produit d’appel », en « écologisme » militant…

– C’est ainsi que, pour prendre un exemple parmi les plus parlants, les conflits dits « religieux » n’ont jamais existé, nulle part, ni au XVIème siècle en France, ni au XVIIème en Europe (la fameuse « Guerre de Trente ans » a vu la France très catholique soutenir les protestants), ni au XXème et XXIème à travers les conflits islamistes, par exemple (on l’a vu dernièrement en Syrie où le terroriste El Joulani, soutenu par Al-Qaïda, s’est brusquement muté en Ahmad al-Charaa, « islamiste inclusif », défenseur de la démocratie et du droit des femmes et de leur liberté à porter ou non le voile, dès que sa recherche insatiable de pouvoir a été satisfaite, oubliant étonnamment vite son « credo » fondamentaliste) : au moment où la politique s’empare d’une situation conflictuelle quelle qu’elle soit, elle change radicalement la nature de l’opposition, la transforme en affrontement « ami » vs « ennemi », c’est-à-dire en guerre plus ou moins déclarée, la politise à l’exclusion de tout autre critère antérieur (qui disparait et ne devient que pur « vecteur » de rassemblement ou de discrimination « ami »/ « ennemi » : où trouve-t-on trace de christianisme dans les massacres des guerres de religion ?) et la porte vite à son paroxysme jusqu’à la domination reconnue d’un parti politique sur l’autre, reconnaissance qui ne peut réellement s’accomplir durablement que sous la tutelle neutralisante et supérieure de l’Etat exerçant seul sa violence souveraine (c’est ainsi du moins que l’Europe s’est pacifiée en 1648 grâce à la naissance de l’Etat moderne)…

– La gauche n’est pas « écologiste » (en quoi les « black-blocs », qui ne cherchent qu’à « se faire du flic », se soucient-ils des méga-bassines ?) : elle a tout simplement saisi ce cheval de bataille, dont le toupet flottait « dans le vent » (le kairos), comme vecteur très efficace pour diffuser son idéologie et recueillir des voix à moindre frais à la suite de l’essoufflement de la vieille idéologie marxiste-léniniste : mieux vaut « défendre la planète » que « la lutte des classes », c’est plus porteur auprès de la jeunesse réseau-socialiste !

– Voilà, Arsène, en quoi votre vocabulaire polémique et celui de vos amis (Anton, MLA, Olivier D., et tant d’autres) n’a finalement rien d’exceptionnel et ne doit pas nous choquer puisqu’il est dans l’ordre des choses (« nihil mirari », disaient les Stoïciens), qu’il confirme même cet « ordre » : l’insulte est une arme comme une autre, au côté de la censure, ou de la soumission de la « science » à l’idéologie politique (comme en d’autres temps : « philosophia ancilla theologiae »), pour asseoir une domination qui n’a décidément vraiment rien de « scientifique »…

Bien le salut !

@Arsène

Il existe un moyen très simple de mesurer la composition de ce qu’il reste de l’atmosphère terrestre entre 50 et 100km d’altitude en y envoyant une fusée en vol balistique suffisamment long et avec le matériel nécessaire pour y faire plusieurs prélèvements.

Cela a certainement été déjà fait et ça suffirait pour clore le débat !

Sans cette confirmation (ou infirmation) vous pédalez dans le vide ou dans la choucroute, au choix.

@Arsène

Le moteur D’I.A. Copilot me donne les résultats suivants donnés par le site

https://videotheque.cnes.fr/index.php?urlaction=doc&id_doc=3267

obtenus par des fusée-sondes du CNES (en Antarctique), de l’ESA et de la NASA:

Alt (km) CO2 (ppm)

0 ~420

20 ~420

50 ~420

80 <100

100 <10

Jack, avez-vous regardé ce documentaire des années 1960 ? Je n’y vois aucune donnée de concentration de CO2 (et le son est très mauvais). A quel moment de ce documentaire de 16 minutes est-ce que les données sont mentionnées ? Je pense qu’il s’agit d’une hallucination d’IA. Dites-moi, s’il vous plaît, où cette information est donnée dans ce documentaire historique, au cas où je l’aurais ratée.

D’ailleurs j’ai testé Copilot à l’instant – il ne comprend pas la différence entre la densité de l’air (qui diminue « vite » avec l’altitude) et la concentration (relative) de CO2 qui diminue aussi mais qui reste de l’ordre de 250 ppm à 100 km. Il fait la même erreur que vous… ou vous la même que lui…

Et même si ce documentaire donne des valeurs de CO2 en fonction de l’atitude (encore une fois, je n’en ai pas vu), qu’est-ce qui vous incite à penser qu’un documentaire grand public des années 1960 serait une source fiable pour vous informer sur les connaissances actuelles ? En particulier, en quoi serait-il plus fiable que des résultats publiés récemment dans les meilleurs journaux scientifiques ? Parce que pourquoi dans ce cas ne pas revenir vers Aristote comme source ultime du savoir définitif en sciences ?

@Arsène,

Pour votre information :

1. Sur la relation entre densité atmosphérique et concentration de CO2 : ppm signifie » partie par million » donc dire que la concentration de CO2 est de 420 ppm dans l’atmosphère signifie que pour un million de molécules d’air, il y a 420 molécules de CO2.

La densité de l’air diminue de manière très rapide avec l’altitude : à 100 km d’altitude, il y a un million de fois de moins de molécules d’air qu’en surface.

Ce qu’il faut conclure de cela qui est très simple à comprendre, c’est que même si le rapport de mélange reste constant, le nombre de molécules dans un même volume d’air diminue très rapidement avec l’altitude et un scientifique honnête doit se poser la question de savoir si on est vraiment capable de mesurer un rapport de mélange de CO2 à 100 km d’altitude alors que le nombre de molécules supposées se trouver dans le même volume a été divisé par un million ?

De plus, personne ne conteste que les 420 molécules de CO2 réchauffe le million de molécules d’autres gaz (oxygène et azote principalement) qui se trouvent autour dans un certain volume, mais de là à réchauffer la surface de la terre il y a un pas scientifique à franchir.

2. Sur la force centrifuge : Je n’ai jamais dit que la force centrifuge était orientée suivant une verticale par rapport à la surface de la Terre. Le problème vient du fait que la Terre est ronde et qu’elle tourne sur elle-même. L’atmosphère est liée à la Terre de telle sorte qu’en première approximation elle tourne à la même vitesse que la Terre dont elle est solidaire. Par conséquent il y a une force centrifuge qui est dans un plan tangent au cercle de rotation d’une particule d’air de l’atmosphère et orientée vers le cosmos uniquement parce que la terre et ronde et pas plate.

Mais vous avez raison, le modèle de Manabé suppose que la Terre est plate, ce qui fait que le problème que je soulève ne se pose pas pour lui.

Si vous voulez comprendre ce dont je parle, vous devez faire une recherche du genre : » Equilibre géostrophique de l’atmosphère « . Si vous mettez seulement » équilibre géostrohique ‘, vous aurez beaucoup de réponses pour l’océan. Regardez quand même parce que pour l’océan le problème est beaucoup plus simple.

Pour l’atmosphère on peut étudier l’équilibre géostrophique dans la troposphère, mais dés qu’on est dans la stratosphère le problème se complique parce que le régime des vents est très différent de celui de la troposphère. Dans la haute stratosphère, la mésosphère et la basse thermosphère il n’est pas possible de définir une force centrifuge, mais la gravité est toujours parfaitement définie ce qui entraîne que les particules lourdes si elles existent encore redescendent vers le bas. Je vous rappelle que dans la haute atmosphère le rayonnement solaire n’a quasiment pas perdu d’énergie et qu’il est efficace pour dissocier le CO2 s’il y en a. C’est un problème de chimie.

Bonjour PP,

J’allais dire en vous lisant : le moyen de résister à une raison comme celle-là ?

Merci en tout cas d’avoir « vulgarisé » le problème pour permettre au « servum pecus » de suivre (de loin) un débat qui m’en rappelle d’autres (à l’époque avec Anton, ou MLA, et bien d’autres encore etc.), où l’acrimonie réchauffiste peut donner toute son incommensurable mesure…

Merci à PP et Phi d’argumenter face de notre contradicteur (sans doute nécessaire) Arsène dont nous ne comptons plus les pseudos.

Ce petit mot pour nous rappeler que cette liberté de dialogue est remise en question par une association grassement financée par nos impôts. Voici un résumé de ce qu’il s’est passé hier.

L’association QuotaClimat, créée en 2022 pour encourager la couverture médiatique des enjeux climatiques, a élargi son action à la lutte contre la « désinformation environnementale » via un Observatoire des médias sur l’écologie, financé par des institutions publiques (Arcom, Ademe, ministère de la Culture, Fondation de France).

Le 22 octobre, elle a organisé à l’Assemblée nationale un colloque sur ce thème, présenté comme parrainé par Yaël Braun-Pivet, qui a démenti tout soutien formel.

Seule Agnès Pannier-Runacher y a défendu la liberté de la presse et mis en garde contre une « bien-pensance climatique ».

QuotaClimat est accusée d’assimiler toute critique de la politique énergétique française à du climato-scepticisme, réduisant ainsi l’espace du débat.

Elle a déjà multiplié les plaintes auprès de l’Arcom, parfois perçues comme des pressions sur les médias.

L’association soutient une proposition de loi déposée par le député Stéphane Delautrette, visant à encadrer plus strictement l’information environnementale et à donner à l’Arcom le pouvoir de sanctionner la « désinformation climatique ».

Pour ses détracteurs, cette démarche revient à institutionnaliser la censure et à imposer une vérité d’État sur la transition énergétique.

Le risque pointé : que des débats légitimes sur le nucléaire, les éoliennes, les coûts ou l’efficacité des politiques climatiques deviennent impossibles au nom de la lutte contre la désinformation.

Il me semble qu’il y a deux ou trois points à préciser à propos de l’état des connaissances en physique de l’atmosphère.

Ce qui est raisonnablement certain:

1. Les GES et autres composantes actifs dans l’IR constituant pratiquement le seul moyen qu’a l’atmosphère de se refroidir, sans ces moyens le gros de sa masse serait beaucoup plus chaud. Environ la température maximale de surface (effet lié à la différence d’efficacité entre convection et conduction) soit pas très loin des 100 °C. Une telle situation conduirait probablement à la disparition de l’atmosphère.

2. C’est cette source froide dans l’atmosphère qui, avec la source chaude de la surface, fait tourner la formidable machine thermique qu’est la troposphère. Cette machine thermique réduit drastiquement les différentiels de température (spatiaux et temporels).

3. Comme les GES et autres composants actifs dans l’IR donnent à l’atmosphère une irradiance non nulle, le refroidissement de la surface en est réduit et sa température moyenne en est augmentée.

4. Le flux thermique convectif n’étant pas accessible au calcul l’effet d’une augmentation d’un composant actif dans l’IR comme le CO2 n’est pas calculable. Il n’y a pas de prédiction possible d’un éventuel réchauffement dû à l’augmentation du taux de CO2.

Les prétendus calculs de l’effet de serre reposent tous sur l’utilisation d’un gradient thermique troposphérique empirique indépendant de la structure radiative. Cette condition absurde n’a jamais été justifiée et l’état des connaissances (mentionné dans Manabe et Stirckler 1964) dément cette supposition. L’existence même d’un gradient dT/dz négatif n’a d’ailleurs pas d’autre explication que l’activité IR de l’atmosphère.

La théorie ne permet donc pas d’éclairer l’effet du CO2 sur les températures de surface. En l’état, les observations (les vraies observations, pas l’incroyable graille que sont les indices de températures de surface) ne permettent pas non plus de détecter fiablement l’effet potentiel de l’augmentation du taux de CO2.

@Arsène

Voici un tableau plus précis des concentration en CO2, en fonction de l’altitude obtenu via Grok 3 Beta:

Altitude (km) Concentration CO2 (ppm) Remarques

50 ~300–350 Similaire à la troposphère, densité réduite

60 ~250–300 Diminution due à la raréfaction de l’air

70 ~200–250 Influence des dynamiques mésosphériques

80 ~150–200 Début de la thermosphère, dissociation accrue

90 ~100–150 Forte diminution, effet des UV

100 ~50–100 Très faible, dissociation et diffusion dominantes

Bonsoir à tous,

Je pense que vous serez intéressés par cet article de Laurence Gould, intitulé » Systematic and Logical Problems in Global Warming Science « , 2014.

Vous le trouverez à l’adresse suivante :

https://www.researchgate.net/publication/279154331_Systematic_and_Logical_Problems_in_Global_Warming_Science

Bien à vous,

PP